Bard vs ChatGPT, AI 챗봇 경쟁 2막 오른다

구글의 람다, 전직 구글 엔지니어가 “지각이 있다”고 주장한 언어생성 모델 중국 바이두도 자체 AI 챗봇 ‘어니’ 공개 예정 ChatGPT가 쏘아 올린 챗봇 경쟁의 신호탄, AI의 근본적 이해 선행돼야

구글이 대화형 AI 서비스를 담당할 새로운 AI인 Bard(바드)를 출시했다. 오픈AI의 AI 챗봇 ‘ChatGPT’가 출시 2개월여 만에 사용자 1억 명을 돌파하며 돌풍을 일으키자 이에 대항할 서비스를 내놓은 것. 바드는 대화 애플리케이션을 위한 구글의 언어 모델인 람다(LaMDA)를 기반으로 하며, 전 세계를 대상으로 하는 구글의 방대한 지식과 대규모 언어 모델의 힘을 보여줄 전망이다.

뒤늦은 참전, 구글의 AI챗봇 ‘Bard’

람다는 1,370억 개에 달하는 매개 변수로 학습한 AI로, 30억 개의 문서와 11억 개의 대화를 익힌 것으로 알려졌다. 람다는 작년 말 한 전직 구글 엔지니어가 챗봇은 “지각이 있다”고 주장하면서 화제가 되기도 했다. 바드는 우선 람다의 경량 모델 버전으로 출시되며 신뢰할 수 있는 테스터에게 먼저 제공된 후 몇 주 내로 대중에게 공개될 예정이다. 이미 구글은 검색 엔진을 개선하고 사용자에게 더 깊은 인사이트와 이해를 제공하기 위해 AI를 활용하고 있지만 소비자 입장에서 잘 실감되지는 않았다. 이제 보다 명확한 AI 기반 검색 기능이 곧 출시될 예정이다. 또한 구글은 개발자가 AI 발전의 혜택을 쉽고 안전하게 누릴 수 있도록 지원할 계획이다.

이번 발표는 오픈AI의 챗GPT가 열풍을 일으키는 가운데 나왔다. 전 세계 검색엔진 시장을 장악해온 구글로서는 챗GPT의 급부상에 빠르게 대응하지 않을 경우 자칫 시장을 빼앗길 수 있다는 위기감이 크다. 구글은 최근 오픈AI 출신 개발자가 창업한 AI스타트업 앤스로픽에 4억 달러를 투자하기도 했다. 예전 구글의 위상과 비교한다면 상대적으로 초라한 모습이다. 제품을 발표하고 시장에 충격을 선사하는 게 일상이던 구글이 이제는 슬금슬금 언론에 발표하면서 우리도 발표할 테니 조금만 기다려 달라 시간만 끌고 있다.

구글이 주춤한 와중에 4차 산업 혁명의 선두를 달리기 위한 AI 챗봇 레이스의 신호탄은 올라갔다. 수십억 달러를 투자할 계획을 밝힌 Microsoft는 이미 일부 제품에 ChatGPT를 통합할 것이라고 밝혔다. 주로 MS의 검색 엔진 ‘빙’에 통합할 계획이라는 소문이 돌고 있다. MS는 구글이 바드 출시 계획을 발표한 지 불과 몇 분 만에 “챗GPT와 관련된 이벤트를 7일 개최하겠다고 발표했다. 챗GPT를 개발한 오픈AI CEO 샘 올트먼은 트위터를 통해 자신이 MS 본사가 있는 워싱턴주 레드먼드에 있다는 사실을 알리면서 “내일 행사를 앞두고 흥분된다”는 트윗을 남기기도 했다. 중국 최대 검색엔진 기업 바이두도 조만간 자체 AI 챗봇 ‘어니’를 공개할 예정이다.

인간 시대의 종말?

이처럼 전 세계의 거대 기업들을 떨게 만드는 인공지능 발전에 대한 일반의 우려가 크다. 인터넷에서는 ‘인간 시대의 종말’이라는 자조가 늘었다. 하지만 제대로 생각하고 훈련된 인간이라면 걱정할 필요는 없다. 최근 몇 년 동안 많은 양의 데이터를 처리하고 분석하기 위해 다양한 계산 방법이 개발되며 AI가 비약적인 발전을 거듭하는 것은 사실이다. 극적인 발전의 디딤돌이 된 핵심 기술 중 하나는 사람의 반응을 활용하여 정확도를 향상시키는 강화 학습(RLHF)이다. 인간의 피드백을 통한 강화 학습은 강화 학습(RL)의 하위 분야로, AI 에이전트의 학습 과정에 인간의 피드백을 더한 것이다. 매우 성공적인 기술이지만, 그 한계를 이해한다면 ‘인간 시대의 종말’을 걱정할 필요가 없다.

RLHF 및 기타 강화 학습 모델은 거칠게 설명하자면 고교 시절에 학습한 미분 최적화와 수열을 대학 수학의 방식으로 수행하는 계산인데, 이를 반복적으로 적용 가능한 경우에만 유용한 ‘동적 최적화’라는 틀을 따른다. 우리가 손으로 계산을 수행하기 위해서는 수식을 갖춰야 하지만, 강화학습 방식은 데이터가 주어지면 그 수식을 역추적해내는 구조의 계산이 이뤄지는 형태다. 덕분에 바둑과 같이 단순한 논리로 인해 복잡한 질서가 만들어지는 데이터들에서 주요한 성과를 보였다. 그러나 단순한 논리로 만들어 내기에는 갖은 종류의 오차가 있는 경우에는 어려움을 겪을 수밖에 없다. RLHF는 그런 오차 보정의 방법 중 하나로, 인간의 반응을 활용하는 변형 계산에 불과하다.

기우(杞憂) : 장래에 대한 쓸데없는 걱정을 일컫는 고사성어

이러한 접근 방식을 ‘현시선호’ 방식이라고 한다. 몇 가지 근본적인 문제가 있는데 그중 하나는 ‘순환논리’의 오류이다. 학문적으로는 이행성(Transivity)이 깨진다고 표현한다. 이를테면 점심으로 김밥과 국밥 중에서는 김밥, 김밥과 제육 중에서는 제육, 국밥과 제육 중에서는 국밥을 고른다고 학습했다. 이제 우리는 국밥을 먹을 바에는 간편한 김밥을 먹고, 김밥을 먹을 바에는 매콤한 제육을 먹고, 제육을 먹느니 다시 뜨끈한 국밥을 먹어야 한다. 고민만 하다가 점심시간이 끝난다.

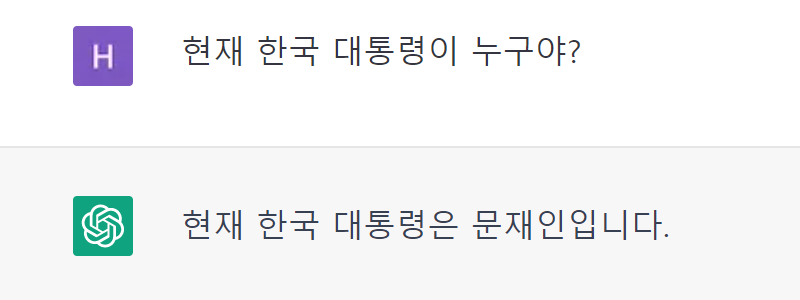

이처럼 인간의 선택이 일관되지 않았을 때처럼 계산을 위한 기본 가정이 깨질 때 강화 학습 알고리즘은 난관에 빠지게 된다. 또한 학교나 대학에서 가르치는 심도 있는 콘텐츠와 같이 전문 지식이 필요한 문제를 해결하는 데에도 한계가 있다. 단순히 오류를 보정하는 방식을 아주 무수히 반복할 뿐이다. 전문화가 아닌 일반화를 찾으려고 하기 때문에 현재의 방식을 아무리 강화시켜도 소위 ‘강한 인공지능’을 만들 수는 없다.

이러한 한계에도 불구하고 RLHF 모델을 구현한 ChatGPT는 계산의 오류를 줄이고 대중이 더 쉽게 접근할 수 있도록 했다. 이는 중요한 성과지만, 인간의 지능을 대체할 수 있는 무언가가 아니라 더 많은 일을 할 수 있는 ‘약한 인공지능’이라는 점을 명심해야 한다. 결론적으로 ChatGPT 및 기타 AI 모델은 데이터 처리 및 분석에 있어 큰 진전을 이루었지만, 현명한 시민이라면 현실적인 기대치를 갖고 그 한계를 이해하며 헛된 기대와 걱정을 지양해야 한다. AI는 특정 작업을 보조하고 더 효율적으로 만들 수는 있지만 근본적으로 인간의 지식과 전문성을 대체할 수는 없다.