[해외 DS] 적절한 밈 생성으로 암호 숨겨주는 AI

생성형 AI를 만나 완벽해진 스테가노그래피 콘텐츠 출처 감지해도 암호화 여부는 몰라 보안과 계산 효율 두 마리 토끼 잡아

[해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (MDSA R&D)에서 영어 원문 공개 조건으로 콘텐츠 제휴가 진행 중입니다.

몇 명의 컴퓨터 과학자들이 스파이와 반체제 인사 모두에게 도움이 될 수 있는 암호화 알고리즘이 등장했다. 연구원들은 외부 관찰자가 메시지가 포함되어 있다는 사실을 발견할 수 없도록 완벽한 보안을 유지하면서 실제 텍스트, 이미지 또는 오디오에 메시지를 숨기는 최초의 알고리즘을 개발했다고 전했다. 과학자들은 최근 열린 표현학습 국제 콘퍼런스에서 이 결과를 발표했다.

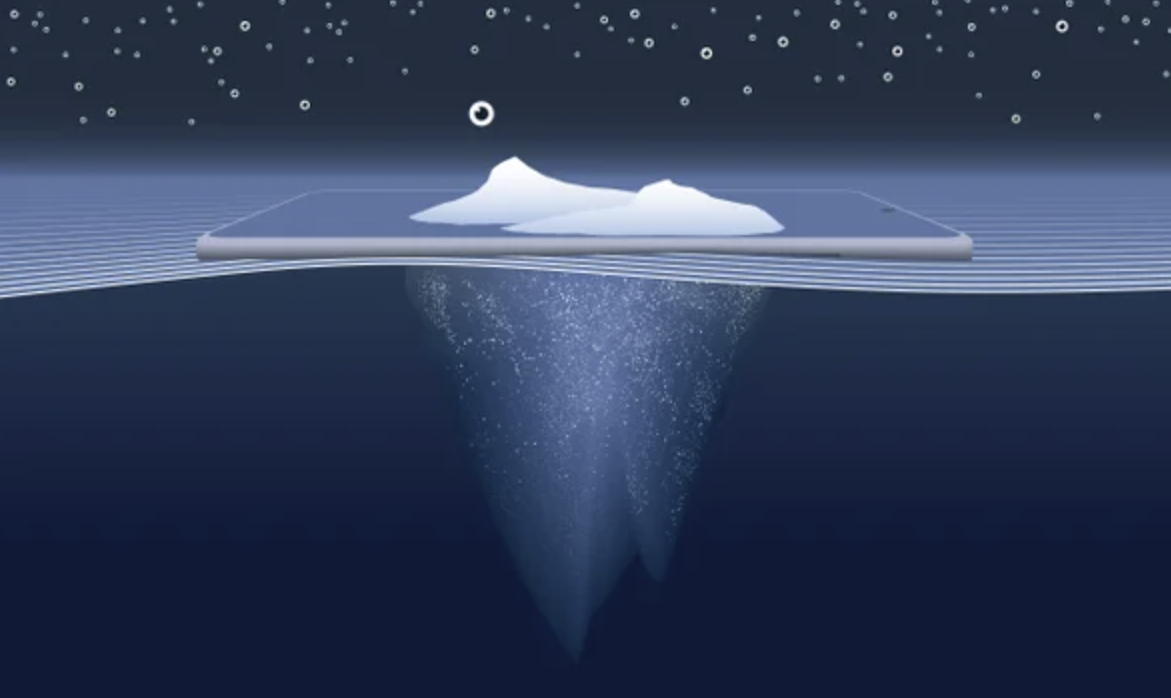

눈에 잘 띄지 않게 비밀을 숨기는 기술을 스테가노그래피라고 하는데, 이는 메시지 자체는 숨기지만 메시지가 공유되고 있다는 사실은 숨기지 못하는 일반적으로 사용되는 암호화(cryptography)와 구별된다. 디지털 스테가노그래퍼는 정보를 안전하게 숨기기 위해 통상적인 대화와 통계적으로 같은 단어 또는 이미지 문자열에 메시지를 삽입한다. 안타깝게도 사람이 생성한 콘텐츠는 완벽한 보안을 달성할 만큼 예측할 수 없으나 인공지능은 정의된 규칙을 사용하여 텍스트와 이미지를 생성하므로 잠재적으로 완전히 탐지할 수 없는 비밀 메시지를 생성할 수 있다.

옥스퍼드 대학교의 연구원 크리스티안 슈뢰더 드 비트(Christian Schroeder de Witt)와 카네기 멜 대학교의 연구원 사무엘 소코타(Samuel Sokota)와 그의 동료들은 AI 프로그램을 사용하여 비밀 내용이 포함된 해가 없어 보이는 채팅 메시지를 생성해 냈다. 슈뢰더 드 비트는 “이 채팅은 동일한 생성 AI가 만든 다른 커뮤니케이션과 구별할 수 없다”라며 “AI가 생성한 콘텐츠가 있다는 것을 감지할 수 있지만, 비밀 정보를 인코딩했는지 알 수 없다”라고 확신했다.

이러한 위장을 달성하기 위해 연구원들은 비밀 메시지를 채팅에서 전송할 일련의 밈(또는 텍스트)과 최적으로 일치시키는 알고리즘을 개발하여 맥락에 맞는 콘텐츠를 즉각적으로 선택하는 게 가능했다. 이상적인 결합 분포(coupling distribution)를 선택하는 방식, 즉 비밀 메시지와 해가 없는 콘텐츠(예: 고양이 밈)를 최대한 상호의존적이면서 두 콘텐츠의 적절한 분포를 유지하는 방식으로 배합는 방식을 고안해 낸 것이 가장 큰 성과였다. 이 접근은 계산적으로 난도가 높지만, 연구팀은 최근 정보 이론의 발전을 통합하여 계산 효율을 개선했다. 메시지 수신자는 동일한 연산을 반전시켜 비밀 텍스트를 알아낼 수 있다.

연구진은 이 기술이 인간과 유사한 생성 AI가 보편화됨에 따라 상당한 잠재력을 가지게 되었다고 얘기했다. 레이던 대학교의 학습 및 혁신 센터의 개인정보 보호 책임자 조안나 반 데르 메르베(Joanna van der Merwe)도 이에 동의했다. 반 데르 메르베는 “권위주의 정권하에서 정보 환경이 매우 제한적이고 비밀스럽고 억압적이므로 해당 기술을 적용하여 인권 침해를 문서로 만드는 것이 가장 먼저 떠오르는 사용 사례다”고 말했다. 이 기술이 이러한 시나리오의 모든 문제를 극복할 수는 없지만 좋은 도구는 될 수 있다고 그녀는 덧붙였다.

In an advance that could benefit spies and dissidents alike, computer scientists have developed a way to communicate confidential information so discreetly that an adversary couldn’t even know secrets were being shared. Researchers say they have created the first-ever algorithm that hides messages in realistic text, images or audio with perfect security: there is no way for an outside observer to discover a message is embedded. The scientists announced their results at the recent International Conference on Learning Representations.

The art of hiding secrets in plain sight is called steganography—distinct from the more commonly used cryptography, which hides the message itself but not the fact that it is being shared. To securely conceal their information, digital steganographers aim to embed messages in strings of words or images that are statistically identical to normal communication. Unfortunately, human-generated content is not predictable enough to achieve this perfect security. Artificial intelligence generates text and images using rules that are better defined, potentially enabling completely undetectable secret messages.

University of Oxford researcher Christian Schroeder de Witt, Carnegie Mellon University researcher Samuel Sokota and their colleagues used an AI program to create innocent-looking chat messages with secret content. To outside observers, the chat is indistinguishable from any other communication made by the same generative AI: “They might detect that there is AI-generated content,” Schroeder de Witt says, “but they would not be able to tell whether you’ve encoded secret information into it.”

To achieve this camouflage, the researchers developed an algorithm to optimally match a clandestine message with a series of memes (or text) to be sent in the chat, choosing that content on the fly to suit the context. Their big step was the way their algorithm chooses an ideal “coupling distribution” on the spot—a method that matches secret bits with innocuous content (for example, cat memes) in a way that preserves the right distributions of both while making them as interdependent as possible. This approach is computationally quite difficult, but the team incorporated recent information theory advances to find a near-optimal choice quickly. A receiver on the lookout for the message can invert the same operation to uncover the secret text.

The researchers say this technique has significant potential as humanlike generative AI becomes more commonplace. Joanna van der Merwe, privacy and protection lead at Leiden University’s Learning and Innovation Center, agrees. “The use case that comes to mind is the documentation of abuses of human rights under authoritarian regimes and where the information environment is highly restricted, secretive and oppressive,” van der Merwe says. The technology doesn’t overcome all the challenges in such scenarios, but it’s a good tool, she adds: “The more tools in the toolbox, the better.”