[해외 DS] 검색엔진, 가짜뉴스에 대한 믿음 증폭시켜 (2)

검색엔진은 사람들의 믿음을 바꿀 수 있으며, 특히 검색 정보가 부족한 상황에서 더 쉽게 믿어 구글 등 기술회사는 잘못된 정보 유포를 막으려 노력하지만 한계가 있어 정확한 정보 검색 방법 교육, 다양한 이해관계자 협력 등 종합적인 해결책이 필요해

[해외DS] 검색엔진, 가짜뉴스에 대한 믿음 증폭시켜 (1)에서 이어집니다.

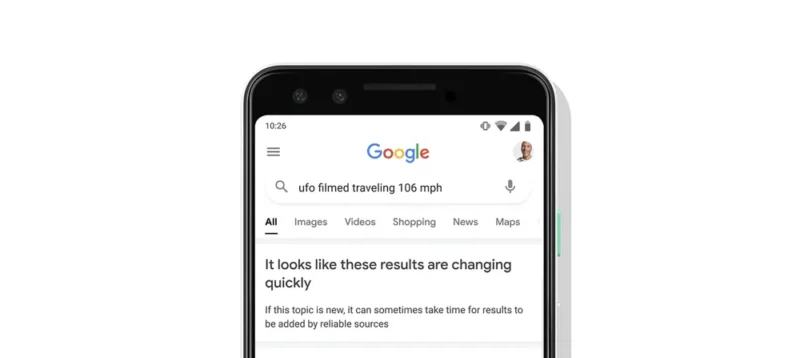

Google과 같은 기술 기업들이 잘못된 정보를 억제하기 위애 노력하고 있지만, 여전히 허위 정보는 곳곳에서 발견되고 있다. 특히 특정 주제에 대한 정보가 희박한 ‘데이터 공백'(data voids)에서 문제가 악화된다. 악의적인 메시지를 퍼뜨리려는 사람들은 종종 데이터 공백을 의도적으로 이용하여 주류 미디어를 우회할 수 있는 용어를 만들어내고, 해당 용어가 음모론적 유행어로 발전할 때까지 여러 플랫폼에서 반복하여 더 많은 오보를 생산한다.

구글 대변인은 이 문제를 해결하기 위해 적극적으로 노력하고 있다고 사이언티픽 아메리칸에 전했다. 예를 들어 구글은 뉴스 속보 내용이 빠르게 업데이트되고 있어 아직 신뢰할 수 있는 결과를 얻지 못할 수 있는 경우, 일부 검색 결과에 경고를 추가하기 시작했다. 뉴스 속보나 새로운 주제의 경우 가장 먼저 게시된 정보가 가장 신뢰할 수 있는 정보가 아닐 수 있기 때문이다. 하지만 데이터 공백을 악용하는 콘텐츠의 노출을 원천 차단하는 것은 불가능하므로 이 문제는 모든 검색 제공업체의 지속적인 도전 과제라고 대변인은 덧붙였다.

검색으로 인한 판단 변화, 정량적 평가 첫 시도

이 연구의 공동 저자인 미국 뉴욕대 사회미디어·정치센터의 전무이사 제브 샌더슨(Zeve Sanderson)은 검색 엔진은 사람들이 인터넷에서 가장 먼저, 그리고 가장 자주 들르는 곳이라고 강조했다. 검색 결과를 기준으로 사람들의 인식이 편향적으로 형성되거나 거짓 정보에 대한 잘못된 신뢰가 쌓이면 사회적 파급력이 걷잡을 수 없이 커지는 이유다. 이러한 파급력에도 불구하고 소셜 미디어 플랫폼에서 잘못된 정보의 확산을 평가한 과학적 연구는 많지만, 검색 엔진에 초점을 맞춘 정량적 평가는 거의 없었다.

그런 의미에서 이번 연구는 검색이 사용자의 신념을 얼마나 변화시킬 수 있는지를 측정하는 유용한 방법을 제시했다. “저의 최근 정성적 연구가 제안한 바를 누군가 정량적으로 입증한 것을 보게 되어 정말 기쁘다”고 메리맥대학의 커뮤니케이션·미디어 조교수인 멜리사 짐다스는 말했다. 2020년 그녀는 ‘가짜 뉴스: 디지털 시대의 미디어와 허위 정보에 대한 이해’를 공동 편집한 바가 있다. 그녀는 많은 인터뷰를 통해 알아낸 검색엔진의 특별한 효과가 있었다고 전했다. 사람들이 온라인에서 보는 정보를 검증하기 위해 검색엔진을 자주 사용하며, 그렇게 함으로써 잘못된 정보가 정당성을 갖춘 것처럼 보인다고 언급하는 사람들이 많았다는 것이다.

연구의 실험적 설정 한계와 가짜뉴스 확산 방지 위한 공동 노력 촉구

그러나 이번 연구에도 한계가 있다. 펜실베이니아 대학교의 컴퓨터·정보과학 조교수인 다나에 메타사는 실험적 설정으로 인해 이 연구가 뉴스를 평가할 때 사람들의 자연스러운 행동을 포착하지 못했다고 지적했다. 이 연구는 모든 참가자에게 검색 여부를 결정할 수 있는 옵션을 제공하지 않았으며, 선택권이 주어졌다면 사람들은 다르게 행동했을 수도 있다고 설명했다. 또한 연구에 참여한 전문 팩트체커들조차도 일부 기사에 혼란을 느꼈다고 스탠퍼드대학의 역사교육그룹 책임자이자 온라인 허위 정보 퇴치에 초점을 맞춘 디지털리터러시커리큘럼을 연구·개발하고 있는 조엘 브레이크스톤은 말했다. 팩트체커들이 기사를 분류하는 방법에 항상 동의하는 것은 아니며, 팩트체커들의 판단이 엇갈린 기사의 경우, 검색이 참가자들의 잘못된 정보에 대한 믿음을 강화하는 경향이 더 강한 것으로 나타났다. 따라서 잘못된 정보에 대한 믿음이 증가한 효과 중 일부는 검색 결과의 영향이 아니라 단순히 혼란스러운 정보의 결과일 수 있다는 것이다.

브레이크스톤 소장의 연구에 따르면, 출처에 대한 정보를 찾아보도록 권장하는 ‘측면 읽기'(lateral reading) 같은 기법은 잘못된 정보에 대한 믿음을 줄일 수 있다고 한다. 팩트체크 기법을 배운 전문가들은 그렇지 않은 비전문가들보다 주어진 페이지에 머무는 시간이 훨씬 짧고, 기사를 띄운 탭 옆에 새로운 탭을 추가하여 검증 자료를 찾아보는 습관이 있다고 강조했다. 또한 이번 연구에서 밝힌 것처럼 용어의 함정을 피하고 검색어를 다양화하는 것도 중요한 전략이다. 따라서 온라인 정보 탐색에 대한 안내는 앞으로 단순히 검색하라고 말하는 대신, 검색 방법과 검색 대상에 대해 훨씬 더 명확하게 설명해야 할 필요가 있다. 즉 개인의 데이터 리터러시를 위한 전략을 넘어, 기술 기업과 온라인 플랫폼, 그리고 정부 지도자들이 협력하여 가짜 뉴스의 유입을 줄이기 위한 유기적인 조치를 취해야 한다는 것이다. 잘못된 정보를 차단할 수 있는 단 하나의 해결책이나 완벽한 ‘구글’ 전략은 없으나 더 나은 정보 생태계를 위해 모두의 노력이 필요하다.

Search engines are often people’s first and most frequent pit stops on the Internet, says study co-author Zeve Sanderson, executive director of New York University’s Center for Social Media and Politics. And it’s anecdotally well-established they play a role in manipulating public opinion and disseminating shoddy information, as exemplified by social scientist Safiya Noble’s research into how search algorithms have historically reinforced racist ideas. But while a bevy of scientific research has assessed the spread of misinformation across social media platforms, fewer quantitative assessments have focused on search engines.

The new study is novel for measuring just how much a search can shift users’ beliefs, says Melissa Zimdars, an assistant professor of communication and media at Merrimack College. “I’m really glad to see someone quantitatively show what my recent qualitative research has suggested,” says Zimdars, who co-edited the book Fake News: Understanding Media and Misinformation in the Digital Age. She adds that she’s conducted research interviews with many people who have noted that they frequently use search engines to vet information they see online and that doing so has made fringe ideas seem “more legitimate.”

“This study provides a lot of empirical evidence for what many of us have been theorizing,” says Francesca Tripodi, a sociologist and media scholar at the University of North Carolina at Chapel Hill. People often assume top results have been vetted, she says. And while tech companies such as Google have instituted efforts to rein in misinformation, things often still fall through the cracks. Problems especially arise in “data voids” when information is sparse for particular topics. Often those seeking to spread a particular message will purposefully take advantage of these data voids, coining terms likely to circumvent mainstream media sources and then repeating them across platforms until they become conspiracy buzzwords that lead to more misinformation, Tripodi says.

Google actively tries to combat this problem, a company spokesperson tells Scientific American. “At Google, we design our ranking systems to emphasize quality and not to expose people to harmful or misleading information that they are not looking for,” the Google representative says. “We also provide people tools that help them evaluate the credibility of sources.” For example, the company adds warnings on some search results when a breaking news topic is rapidly evolving and might not yet yield reliable results. The spokesperson further notes that several assessments have determined Google outcompetes other search engines when it comes to filtering out misinformation. Yet data voids pose an ongoing challenge to all search providers, they add.

That said, the new research has its own limitations. For one, the experimental setup means the study doesn’t capture people’s natural behavior when it comes to evaluating news says Danaë Metaxa, an assistant professor of computer and information science at the University of Pennsylvania. The study, they point out, didn’t give all participants the option of deciding whether to search, and people might have behaved differently if they were given a choice. Further, even the professional fact-checkers that contributed to the study were confused by some of the articles, says Joel Breakstone, director of Stanford University’s History Education Group, where he researches and develops digital literacy curriculums focused on combatting online misinformation. The fact-checkers didn’t always agree on how to categorize articles. And among stories for which more fact-checkers disagreed, searches also showed a stronger tendency to boost participants’ belief in misinformation. It’s possible that some of the study findings are simply the result of confusing information—not search results.

Yet the work still highlights a need for better digital literacy interventions, Breakstone says. Instead of just telling people to search, guidance on navigating online information should be much clearer about how to search and what to search for. Breakstone’s research has found that techniques such as lateral reading, where a person is encouraged to seek out information about a source, can reduce belief in misinformation. Avoiding the trap of terminology and diversifying search terms is an important strategy, too, Tripodi adds.

“Ultimately, we need a multipronged solution to misinformation—one that is much more contextual and spans politics, culture, people and technology,” Zimdars says. People are often drawn to misinformation because of their own lived experiences that foster suspicion in systems, such as negative interactions with health care providers, she adds. Beyond strategies for individual data literacy, tech companies and their online platforms, as well as government leaders, need to take steps to address the root causes of public mistrust and to lessen the flow of faux news. There is no single fix or perfect Google strategy poised to shut down misinformation. Instead the search continues.