[해외 DS] CNN의 대체 주자 KAN, 설명가능한 신경망 모델 등장하나 ①

테크 기업, 챗봇 근본적인 문제 고치지 않고 출시하는 것에만 몰두해

보편 근사 정리에 따르면 신경망 모델로 원하는 함수의 근사치 구할 수 있어

하지만 막대한 자원이 필요하며 해석 불가능하다는 한계 가져

[해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 글로벌AI협회(GIAI)에서 번역본에 대해 콘텐츠 제휴가 진행 중입니다.

ChatGPT는 챗봇 전쟁의 신호탄 역할을 했다. 오픈AI가 대형언어모델(Large Language Model, LLM)기반 챗봇인 ChatGPT를 선보인 이후 테크 기업은 너도나도 할 것 없이 빠르게 챗봇을 개발했다. 메타는 2023년 초에 라마를 출시했으며 구글은 발 빠르게 바드를 선보였다. 하지만 챗봇의 고유한 문제점인 ‘환각’ 증상은 고쳐지지 않은 채 출시에만 힘을 쏟고 있는 상황이다. 최근 등장한 KAN(Komogolov-Anold Network)은 신경망 모델이 갖는 한계를 극복할 수 있을 것이라는 평가를 받고 있다.

신경망 모델의 한계 ‘해석 불가능’

LLM이 홍수처럼 쏟아져나오고 있지만, LLM이 갖는 한계도 명확하다. 모델을 학습하기 위해서는 많은 시간과 컴퓨팅 자원을 사용해야 하며 결과가 어떻게 도출됐는지 알 수 없다. 사용자가 챗봇에 무언가를 입력하면 중간 과정 없이 결과를 내놓는다. 따라서 인공지능 모델이 만든 결과물이 ‘환각’인지 의미 있는 결과인지 파악하기 어렵다. 결과물이 의미 있는 답변인지 아닌지는 사용자가 판단해야 할 몫으로 떠넘긴다.

여러 기업에서는 인공지능 모델의 문제점을 해결하기 위해 더 많은 데이터로 학습시키거나 수학 문제 풀이와 같이 특정 작업에 최적화하는 방법을 꾀한다. 그러나 이러한 시도는 모델의 기본 원리를 바꾸지 못해 근본적인 문제점을 해결할 수 없다. LLM을 포함한 대부분 인공지능 모델은 ‘신경망’ 알고리즘을 기반으로 하기 때문이다. LLM의 근간이 되는 신경망 모델에 대해 자세히 알아보자.

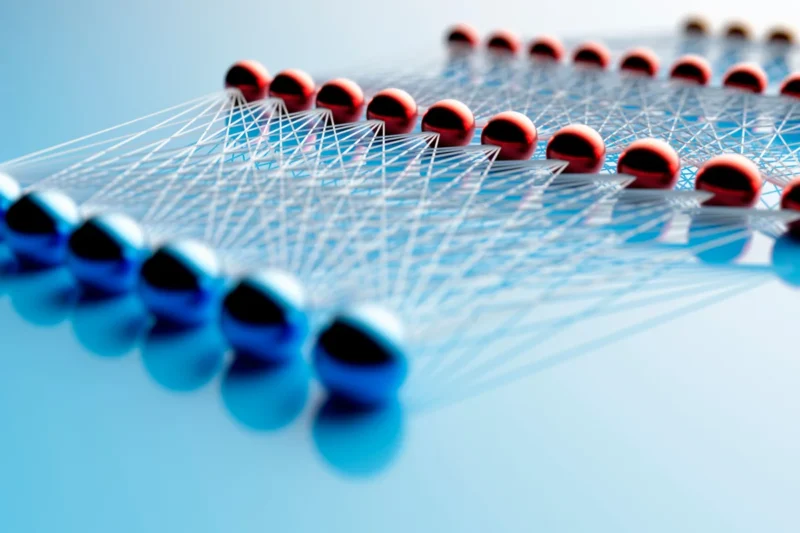

인간 뇌를 본뜬 신경망 모델

신경망 모델은 뇌 신경망에서 영감을 얻었다. 뇌에는 여러 뉴런이 있으며 시냅스로 연결되어 있다. 이를 본떠 신경망 모델은 여러 개의 뉴런으로 배열되어 있으며 시냅스로 연결되어 있는 구조다. 신호는 앞에서 뒤로 전파되며 각 층에서 처리된다. 신경망 모델이 유행하기 전에는 의사 결정 트리와 SVM(Support Vector Machine) 등 다양한 머신러닝 알고리즘이 있었으나, 2010년대 이후 대다수 애플리케이션에서 신경망 모델로 통합되었다. 신경망 알고리즘 아이디어는 1950년대에 등장했으나 주목받지 못하고, 컴퓨터 성능이 폭발적으로 향상된 2010년대 들어서야 빛을 봤다.

그럼 신경망 모델은 어떻게 학습할까? 입력 값(데이터)은 첫 번째 층의 ‘뉴런’으로 전송된다. 그런 다음 ‘시냅스’의 가중치를 곱하고 결과가 특정 임곗값을 넘으면 다음 층으로 전달한다. 이 작업을 최종 층에 도달할 때까지 반복한다. 학습하는 동안 신경망은 원하는 출력을 생성하도록 시냅스의 가중치를 조정할 수 있으며 안정적인 결과를 도출하기 위해서는 많은 데이터가 필요하다.

신경망 모델을 뒷받침하는 ‘보편 근사 정리‘

신경망 모델은 어떻게 다른 머신러닝 모델을 제치고 강력한 모델로서 자리를 잡았을까? 예를 들어 손글씨 숫자 이미지를 인식하는 작업을 맡았다고 가정하자. 입력 데이터는 이미지 픽셀이 되고 최종 출력은 0~9중 한 가지 값이다. 수학적으로 표현하면 y=f(x1, x2, x3, …)로 나타낼 수 있다. 하지만 간단한 데이터가 아닌 이미지 픽셀 데이터로 손글씨를 인식하는 함수를 찾을 수 있을까? 안타깝게도 함수를 찾아내기란 불가능에 가깝다. 따라서 우리는 근사치를 찾는 것에 만족해야 하는데, 보편 근사 정리(Universal Approximation Theorem)에 따르면 신경망 모델은 복잡한 함수의 근사치를 찾을 수 있다.

이 정리는 신경망 모델이 원하는 정확도로 어떤 함수를 근사할 수 있다는 정리다. 신경망을 수학적으로 표현하면 간단하다. 뉴런(데이터)에 시냅스(가중치)를 곱하는 작업을 무수히 많이 한 것이다. 간단한 작업으로 원하는 함수를 근사할 수 있다는 것이 신경망 모델의 힘이다. 게다가 최근 몇 년 동안 전문가들은 특정 유형의 함수를 근사하기 위해 신경망이 구성해야 하는 최소한의 층 수를 증명했다.

해석 가능한 신경망 모델 등장

기존 신경망 모델은 근사치를 찾을 수 있다는 큰 장점이 있지만, 정확한 함수를 정의하지 못해 모델을 해석할 수 없다는 한계를 갖는다. 이것이 우리가 신경망 모델을 ‘블랙박스’라고 부르는 이유다. 하지만 최근 MIT 물리학자 지밍 류가 이끄는 팀은 기존 신경망 모델을 뛰어넘는 모델을 개발한 것으로 알려졌다. 연구진은 이른바 ‘KAN’이라고 불리는 모델을 개발했다. 이 모델의 가장 큰 장점은 기존 신경망 모델과 달리 결과를 재현할 수 있다는 점이다. 전문가들은 KAN을 LLM에 통합하여 성능을 향상시킬 뿐만 아니라 결과를 해석하는 챗봇이 나오길 기대하고 있다. 다음 글에서 KAN 모델이 어떻게 신경망 모델이 가진 한계를 극복했는지 알아보자.

[해외 DS] CNN의 대체 주자 KAN, 설명가능한 신경망 모델 등장하나 ②로 이어집니다.

*편집진: 영어 원문의 출처는 사이언티픽 아메리칸(Scientific American)으로 본지의 편집 방향과 일치하지 않을 수도 있습니다.