Carousel

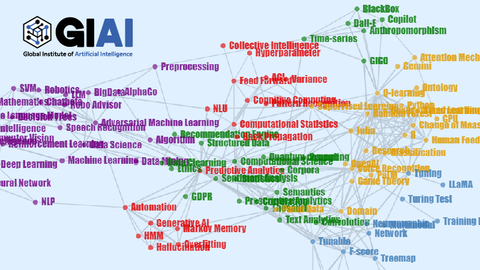

GIAI Korea Discussions

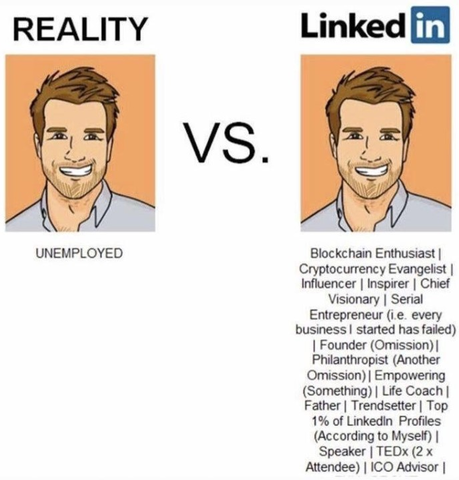

‘인간 윤석열’ 10년 취재기, ‘대전 유배’ 당시 술자리의 그였다면… 다른 부분들은 크게 눈에 안 들어오는데, 원래 순수하고, 사람을 대하는 것도 넉넉했던 사람이 칼 같이 변해있었다는 부분이 눈에 너무 크게 들어옵니다. 저도 이렇게까지 날이 선 사람은 아니었고, 그냥 순진하게 AI/Data Science 가짜 교육하는거에 거부감만 표현하는 사람에 불과…

Read More[유니콘 돋보기] 스타트업과 플립 - 조선비즈 저희 기사 쓸 자료 던져주다가 위의 기고 글을 봤는데, 왜 플립을 하려는건지 정리해 놓은 이유를 보니, 미국 벤처캐피털의 투자를 받기 위해 반도체, 데이터 사이언스, AI 등 첨단 분야 인재 유치를 위해 주요 거래처가 해외에 있는 경우 비즈니스 모델이 한국에서는 불법이지만 해외에서는 합법인 경우 …

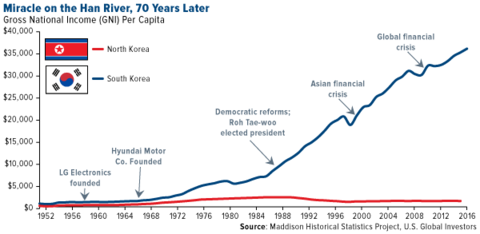

Read More“美가 만든 기술 모방만… 한국 R&D엔 R 없고 D만 있다” “외국에서 오래 공부한 한국 교수와 학생들은 이미 세계적인 수준이다. 문제는 그들을 연구에 전념할 수 없게끔 하는 한국의 문화다. 연구 과제를 선정할 때 한국에서 가장 먼저 하는 질문은 ‘미국에서 하고 있느냐’는 것이다. 새로운 학문과 기술에 대해 연구를 시작하지 않고 미국이 이미… read more

Read More고교 무상화의 역설… 동네 유일의 공립고가 폐교했다 [방구석 도쿄통신] 반값 등록금을 압박하고 있는 한국 교육부가 교훈으로 삼을만한 현상입니다. 가격 낮추면 좋냐? 돈 내는 사람 입장만 생각말고, 돈 받는 사람 입장도 생각해보세요. 월급 절반으로 깎아서 드릴려고 하는데 일 하러 오실래요? 2025년부터 한국 시장 버리기로 결정하고 나니 바로 SIAI 등…

Read More행안부, ‘공무원 AI 교육’ 네이버에 위탁 - 조선비즈 이런거 보면 한국에서 세금 내기가 싫습니다. 내가 낸 세금인데 왜 나는 저런 돈 낭비를 그냥 지켜만 보고 있어야 할까…

Read MoreAll Giai Korea Books

SIAI 설립 이야기

All Researches