[논문이야기] 측정오차 하 광고 시계열 모델링 연구 ④

포아송 칼만 필터와 포아송 시계열 모형의 성능 비교 데이터 수의 증가에 따라 포아송 시계열 모형의 MAE 크게 낮아져 머신러닝의 ‘앙상블’ 기법으로 두 모형의 장점만 살린다

[논문이야기] 측정오차 하 광고 시계열 모델링 연구 ③에서 이어집니다.

이전 글까지를 통해 예측적(Predictive) 및 해석적(Analytic) 관점에서 측정오차를 살펴봤습니다. 이번에는 측정오차 문제를 보정하는 포아송 칼만 필터(Poisson Kalman Filter)을 살펴보고, 나아가 이를 포아송 시계열 모형과 결합하는 ‘앙상블’ 모형을 소개하는 시간을 가져보죠.

포아송 칼만 필터, 측정오차, 베이지안, 그리고 정규화

칼만 필터는 연구자가 이미 알고 있는 변수의 정보(State Equation, 상태 방정식)와 실제 관측한 값(Observation Equation, 측정 방정식)을 토대로 둘 사이의 합의점을 찾아내는 모형입니다. 이는 베이지안(bayesian) 관점에서 연구자가 가진 사전 정보(Prior)와 데이터로부터 획득한 가능도(Likelihood)를 결합하는 것과 동일한 맥락이라고 볼 수 있겠습니다.

바로 이전 글에 소개한 측정오차의 ‘정규화(Regularization)’ 역시 베이지안 관점으로 해석할 수 있습니다. 베이지안 모델링에서 $\beta = 0$이라는 사전 믿음을 얼마나 강하게 가지고 갈 것이냐가 결국 정규화의 아이디어와 같기 때문입니다. 또한 이전 글에서 (랜덤)측정오차 계수를 0으로 끌고 갔던 점 기억하시나요? 즉 칼만 필터, 베이지안, Regularization, 측정오차의 직관이 서로 이어지고 있는 것이죠. 따라서 칼만 필터를 사용한다는 것은 결국 상태 방정식(State Equation)을 통해 측정오차를 반영하겠다는 것과 같은 의미이며, 나아가 정규화까지 반영하는 것임을 이해할 수 있겠습니다.

한편 측정 방정식(Observation Equation)은 어떻게 세워야 할까요? 우리가 다뤄야 할 종속변수는 가산(Count) 데이터므로 일반화선형모형(Generalized Linear Model)의 로그-링크(log-link)를 활용한다면 합리적으로 모델링할 수 있습니다.

포아송 시계열 모형 vs 포아송 칼만 필터

포아송 시계열 모형과 포아송 칼만 필터의 성능을 비교해봅시다. 먼저 로그가능도를 살펴보면 포아송 시계열 모형이 전 구간에서 높음을 확인할 수 있습니다. 반면 MAE를 살펴보면 이번에는 포아송 칼만 필터가 우월한 성능을 보이고 있습니다. 이는 포아송 시계열 모형이 포아송 칼만 필터 대비 과적합됐음을 나타내는 것입니다. 연산 시간 측면에서도 포아송 칼만 필터가 우월한 모습을 보이기는 하는데요, 사실 두 모형 모두 계산에 2초가 채 걸리지 않기 때문에 실제 서비스에 적용하는데 크게 고려해야 할 요소는 아닌 것으로 보입니다.

한편 위 표를 곰곰이 살펴보면 재밌는 부분을 찾을 수 있습니다. 데이터의 수가 증가함에 따라 줄어드는 MAE의 ‘폭’이 포아송 칼만 필터보다 포아송 시계열 모형이 압도적으로 컸다는 것입니다. 이에 대한 이유는 아래와 같습니다.

포아송 칼만 필터의 경우 초반 상태 방정식을 잘 반영해 예측 정확도(MAE) 측면에서 큰 이득을 가져왔으나, 데이터 크기가 증가하더라도 관측 방정식(Observation Equation)에서 데이터를 합리적으로 반영하지 못해 데이터의 수의 증가에 따른 MAE 개선 속도가 확연히 감소했습니다. 반면 포아송 시계열 모형은 모형 과적합으로 인해 초반 예측 정확도에서 손해를 많이 봤으나 지속적으로 획득하는 데이터를 합리적으로 반영하며 MAE가 큰 폭으로 개선된 것입니다.

모델의 강건함(Robustness) 검정에서도 유사한 결과가 도출됐습니다. 즉 잔차(residual)의 자기상관성(Autocorrelation), 평균-분산 관계(mean-variance trade-off), 정규성 등의 검정에서 데이터 수가 작은 초반에는 포아송 칼만 필터가 우수한 성능을 보였던 반면 중반부 이후에는 포아송 시계열 모형이 우수하게 나타났습니다.

Ensemble: Stacking Method

지금까지의 논의을 토대로 두 모형이 가지는 이질적인(Heterogeneous) 장점들을 결합해(Stacking) 하나의 앙상블(Ensemble) 모형을 구축해보겠습니다.

편차(Bias)와 분산(Variance)를 동시에 고려하기 위해 MAE를 최소화하는 스태킹 모델(Stacked model)의 제약식은 다음과 같이 설정하겠습니다.

\[p_{t+1} = argmin_{p}\sum_{i=1}^{t}w_{i}|y_{i} – (p * \hat{y}_{i}^{(GLM)} + (1 – p) * \hat{y}_{i}^{(KF)})|\]

\[s.t. 0 \leq p \leq 1, \forall w > 0\]

이 때 앞서 살펴봤듯 모든 구간에서 포아송 칼만 필터의 MAE가 더 낮았기 때문에, MAE가 ‘개선되는’ 모멘텀(Momentum)을 반영해주지 않는다면 스태킹 모델은 모든 구간에서 p=0을 출력하게 될 것입니다. 즉 포아송 칼만 필터만을 100%로 사용한다는 것이죠. 그러나 데이터의 수가 꽤 많아지는 중후반시점부터 포아송 시계열 모형의 MAE가 크게 개선되는 만큼, 절대값의 제약식 앞에 가중치 W를 곱했습니다.

가중치는 어떻게 부여하는 것이 합리적일까요? 우선 데이터 사이즈가 커질수록 (대수의 법칙에 의해) 두 모형이 점차 합리적으로 변했을 것이므로, 분산 또한 작아질 것입니다. 또한 두 모형 중, 더 좋은 쪽이 상대적으로 분산이 낮겠죠. 따라서 분산의 역수만큼 가중치를 높게 부여한다면 시간이 지날수록 모형이 정확해지는 것을 반영하게 될 것입니다.

가중치를 반영한 최종 모형의 예측치는 아래와 같습니다.

\[\hat{y}_{t+1} = p_{t+1}\hat{y}_{t+1}^{(GLM)} + (1 – p_{t+1})\hat{y}_{t+1}^{(KF)}\]

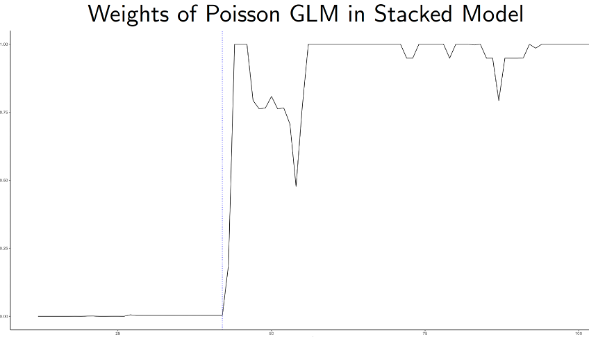

실제 위의 앙상블 모델로 데이터를 분석해본 결과, 초반부에는 p(앙상블 모델에서의 포아송 시계열 모형의 비중)가 0근처에 머무르다가, 중반부터는 1 근처로 껑충 뛰는 것을 확인할 수 있습니다. 또한 데이터의 패턴이 변화하는 중후반 일부 구간에서는 상태 방정식의 장점을 살릴 수 있는 포아송 칼만 필터도 함께 사용하는 것을 엿볼 수 있습니다.

위 표에서 앙상블 모델의 MAE를 살펴봅시다. 이질성(Heterogeneity)을 보이는 두 모형을 합리적으로 결합함으로써 모든 구간에서 두 모형 대비 MAE가 낮은 것을 확인할 수 있습니다. 또한 로버스트 검정에서도 앙상블의 장점이 극대화되면서 개별 모형 대비 더 견고했음을 확인할 수 있었습니다.

결론

응용통계, 계량경제, 머신러닝, 데이터 사이언스 리그는 주 관심 분야나 특장점이 다를 수 있으나, 결국 공통적으로 고민하는 것은 “현실세계에서의 문제를 어떻게 합리적으로 정량화할 수 있을까”로 귀결됩니다. 또한 이 과정에서 해당 문제가 속하는 도메인에 대한 이해는 필수적일 것입니다.

본 [논문이야기]에서는 디지털 광고 도메인에서 흔히 발생하는 측정오차 문제를 바탕으로, 이것이 예측적・해석적 모델링에서 각각 어떠한 영향을 줄 수 있는지 설명하는데 포커스를 뒀습니다. 이를 위해 도메인 환경(광고 업계) 및 DGP(Data Generating Process)에 맞는 ‘포아송 시계열 모형’ 및 ‘포아송 칼만 필터’ 두 모형을 제시했으며, 두 모형이 서로 강한 이질성(Heterogeneity)를 보이는 점에 착안해 앙상블 보형을 최종적으로 제안했습니다.

디지털 전환이 가속화되면서, 관련 기술과 방법론의 성장에 힘입어 데이터 디지털 광고 시장은 앞으로도 폭발적으로 성장할 것입니다. 모쪼록 본 [논문이야기]를 읽고 있는 여러분들도 바쁘게 텍스트를 머릿 속에 넣는 것 보다는, 여유롭게 지식을 음미하며 통계학이 어떻게 데이터 사이언스 및 인공지능 분야에 적용되는지에 대한 외연을 넓힐 수 있다면 좋겠습니다.

![[논문이야기] 부동산 경매시장의 버블 ③](https://kr.giai.org/wp-content/uploads/sites/3/2022/11/아파트전경사진-768x576.webp)

![[논문이야기] 우리나라 제약업은 연구개발 중심일까 카피약 판매 중심일까? ①](https://kr.giai.org/wp-content/uploads/sites/3/2022/07/리베이트-처벌-변화과정.webp)

![[논문이야기] 수면 상태 감지 ④, 일반화에 초점을 맞춰 수면·활동 분포를 활용한 우도비 비교 방법론](https://kr.giai.org/wp-content/uploads/sites/3/2024/04/Sleep_State_Detection_MDSA_YeonsookKwak_15.png)

![[해외 DS] 오펜하이머가 주장하는 AI 개발의 위험성](https://kr.giai.org/wp-content/uploads/sites/3/854EC5EC-180D-48D6-954CFCFE7507B9B2_source.webp)

![[논문이야기] 혈액 보유량은 어떻게 유지될까? ② 혈액 공급량 모델링](https://kr.giai.org/wp-content/uploads/sites/3/2024/04/연간주기-제거-후-잔차분포.png)

![[논문이야기] 수면 상태 감지 ⑤, 한계 및 추후 연구 계획](https://kr.giai.org/wp-content/uploads/sites/3/2024/04/cute-girl-sleeping-on-a-yellow-couch-10496228-1024x683-768x512.jpg)