[해외 DS] AI 챗봇도 인간처럼 느끼고 생각할 수 있을까?

25년 내기의 결말과 아직 끝나지 않은 논쟁 IIT는 종합적 사고, GNWT는 단발적 사고에 초점 핵심은 지능이 아닌 의식

[해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (MDSA R&D)에서 영어 원문 공개 조건으로 콘텐츠 제휴가 진행 중입니다.

주관적 경험이란 무엇이며, 누가 그것을 가졌는지, 그리고 그것이 우리 주변의 물리적 세계와 어떻게 관련되어 있는지에 대한 질문은 오랜 시간 동안 철학자들의 관심을 끌어왔다. 그러나 정량화할 수 있고 경험적으로 테스트할 수 있는 의식 이론의 등장은 수십 년밖에 안 됐다. 이러한 이론의 대부분은 의식이 생겨나는 뇌의 신경 활동에 초점을 맞추고 있다.

이러한 의식의 흔적을 추적하는 데 있어 그 진전이 매우 분명하게 드러나는 행사가 열렸었다. 6월 뉴욕대학에서 열린 공개 행사에서 오늘날 의식의 두 가지 지배적인 이론인 ‘정보 통합 이론'(Integrated Information Theory, 이하 IIT)과 ‘전역 작업 공간 이론'(Global Neuronal Workspace Theory, 이하 GNWT)의 지지자들 간의 ‘적대적 협력’을 통해 선의의 경쟁이 펼쳐졌고, 관점의 다양성은 어지러울 정도였다. 그리고 이 행사의 하이라이트는 뉴욕대학교의 철학자 데이비드 차머스(David Chalmers)와 필자 사이의 25년 전 내기의 결말이었다.

필자는 차머스에게 고급 와인 한 상자를 걸고 2023년 6월까지 의식의 신경 상관관계라고 불리는 이 신경 활동이 명확하게 발견되고 설명할 수 있게 될 것이라고 내기를 걸었다. 하지만 IIT와 GNWT 간의 대결은 아직도 해결되지 않은 채로 남아있다. 왜냐하면 시각적 경험과 얼굴이나 물체를 보는 주관적 감각을 담당하는 뇌의 영역에 관한 주장이 상충하기 때문이다. 그래서 필자는 내기에서 졌고 와인을 찰머스에게 선물했다.

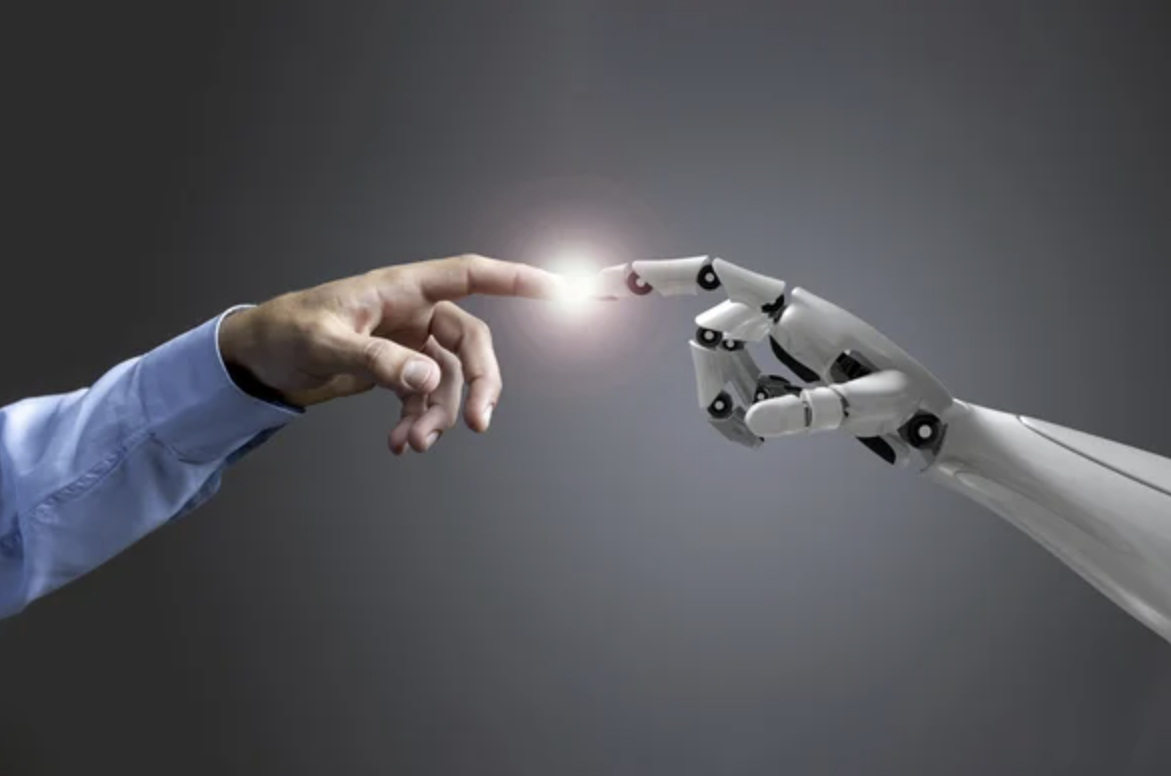

이 두 가지 지배적인 이론은 사람이나 동물의 신경 활동과 의식의 관계를 설명하기 위해 개발되었다. 그러나 주관적 경험에 대해 근본적으로 다른 가정을 하고 있으며, 인공 지능의 의식과 관련하여 상반된 결론에 도달한다. 따라서 추후 해당 이론의 실증적 검증 결과는 기계가 지성을 가질 수 있는가에 대한 질문의 답과 매우 밀접한 관계를 맺게될 것이다.

챗봇의 지능

본론에 앞서 의식이 있는 기계와 지능적인 행동만 보이는 기계의 차이점을 알아보자. 컴퓨터 엔지니어들이 추구하는 성배는 호모 사피엔스가 아프리카를 벗어나 지구 전체로 뻗어나갈 수 있게 해준 고도로 유연한 지능을 기계에 부여하는 것이다. 이를 ‘인공 일반 지능'(이하 AGI)이라고 한다. 많은 사람이 AGI는 먼 목표라고 주장했으나 지난 한 해 동안 인공 지능의 놀라운 발전은 전문가를 포함한 전 세계를 놀라게 했다. 챗봇이라고 불리는 유창한 대화형 애플리케이션의 등장은 공상과학 애호가와 실리콘 밸리 괴짜들 사이의 난해한 주제에서 우리 삶의 방식과 인류에 대한 실존적 위험에 대한 대중의 일상 논쟁으로 확산했다.

이러한 챗봇은 대규모 언어 모델(이하 LLM)에 의해 구동되며, 가장 유명한 것은 OpenAI에서 만든 GPT라는 챗봇이다. OpenAI의 가장 최근 모델인 GPT-4의 유동성, 문해력 및 역량을 고려할 때, 이 챗봇이 인격을 가지고 있다고 믿기 쉽다. 심지어 ‘환각’으로 알려진 결함조차도 인격을 가진 결과라고 믿는 경우가 생겼다.

GPT-4와 그 경쟁자, 즉 Google의 LaMDA와 Bard, Meta의 LLaMA 등은 웹 크롤러를 통해 공개적으로 액세스할 수 있는 디지털 라이브러리와 수십억 개의 웹 페이지를 학습했다. LLM의 놀라운 점은 자동으로 단어 한두 개를 가리고 누락된 표현을 예측하는 방식으로 스스로 학습한다는 점이다. 이 과정은 누구의 개입도 없이 수십억 번을 반복해서 수행된다. 인류의 디지털 글을 수집하여 학습을 마치면 한 사용자가 모델이 한 번도 본 적이 없는 문장을 입력한다. 그러면 가장 가능성이 높은 단어와 그다음 단어를 예측하는 방식으로 응답한다. 이 간단한 원리로 영어, 독일어, 중국어, 힌디어, 한국어를 비롯해 다양한 프로그래밍 언어를 포함한 더 많은 언어에서 놀라운 결과를 얻었다.

1950년 영국의 논리학자 앨런 튜링이 ‘계산 기계와 지능’이라는 제목으로 쓴 에세이는 “기계가 생각할 수 있는가”라는 주제를 피했다. 대신 튜링은 ‘모방 게임’을 제안했다. 인간과 기계의 정체가 숨겨져 있을 때 관찰자가 인간과 기계가 입력한 결과물을 객관적으로 구별할 수 있는지를 묻는 실험이다. 오늘날 이 실험은 튜링 테스트로 알려져 있으며, 챗봇은 이 테스트를 가볍게 통과했다. 튜링의 전략은 수십 년에 걸친 끊임없는 발전을 통해 GPT로 이어졌지만 근본적인 질문은 해소하지 못했다.

이 논쟁에는 인공 지능이 인공 의식과 동일하며, 똑똑하다는 것은 의식이 있다는 것과 같다는 가정이 내포되어 있다. 인간과 같은 진화한 유기체에서는 지능과 의식이 함께 존재하지만, 꼭 그럴 필요는 없다. 지능은 궁극적으로 행동하기 위해 추론하고 학습하는 것, 즉 자기 행동과 다른 자율적 생물의 행동을 학습하여 향후 몇 초(“어머, 저 차가 빠르게 다가오고 있어”)나 향후 몇 년(“코딩하는 법을 배워야 해”)을 더 잘 예측하고 대비하는 것을 의미한다. 지능은 궁극적으로 실행에 관한 것이기 때문이다.

반면에 의식은 푸른 하늘을 보고, 새가 지저귀는 소리를 듣고, 고통을 느끼고, 사랑에 빠진 상태와 같은 존재의 상태에 관한 것이다. 인공지능이 날뛸 때 어떤 감정을 느끼는지는 조금도 중요하지 않다. 중요한 것은 인공지능이 인류의 장기적인 행복에 부합하지 않는 목표를 가지고 있다는 점이지, AI가 자신이 무엇을 하려고 하는지를 알고 있는지는 중요하지 않다. 따라서 적어도 개념적으로 AGI를 달성했다면, 그런 AGI가 되는 것이 어떤 느낌인지에 대해서는 알 수가 없을 것이다. 이 미장센을 통해 두 가지 이론 중 첫 번째 이론부터 시작하여 기계가 어떻게 의식을 갖게 될 수 있는지에 대한 원래의 질문으로 돌아가 보자.

IIT는 생각할 수 있는 주관적 경험의 다섯 가지 공리적인 속성을 공식화하는 것으로 시작한다. 그런 다음 신경 회로가 일부 뉴런을 켜고 끄는 방식으로 이 다섯 가지 속성을 인스턴스 화하는 데 필요한 것이 무엇인지, 또는 컴퓨터 칩이 일부 트랜지스터를 켜고 끄는 데 필요한 것이 무엇인지 묻는다. 특정 상태의 회로 내 인과적 상호 작용 또는 특정 뉴런 두 개가 함께 활성화되면 다른 뉴런을 켜거나 끌 수 있다는 기초적인 사실은 고차원적인 인과 구조로 전개될 수 있다. 이 구조는 시간이 흐르고 공간이 확장된 느낌, 색이 특정 모양을 띠는 이유와 같은 경험의 질, 즉 느낌의 질과 동일하다. 이 경험은 또한 관련된 양, 즉 통합된 정보를 가지고 있다. 통합 정보가 0이 아닌 최댓값을 가진 회로만이 의식이 있을 가능성이 높다. 통합 정보가 클수록 회로는 환원 불가능하며, 독립적인 하위 회로의 중첩으로만 간주할 수 없기 때문이다. IIT는 인간 지각 경험의 풍부한 본질을 강조한다. 주위를 둘러보면 무수한 구분과 관계로 가득한 시각적 세계를 볼 수 있고, 종교적 주제와 농부들의 모습을 그린 16세기 플랑드르 화가 피터르 브뤼헐의 그림을 보면 알 수 있다.

상호연결의 복잡성

인간의 뇌와 같은 연결성과 인과 구조를 가진 모든 시스템은 원칙적으로 인간의 마음처럼 의식이 있을 것이다. 이러한 시스템은 시뮬레이션할 수 없기 때문에 인간의 뇌와 비슷하게 구성되어 있어야 한다.오늘날의 디지털 컴퓨터는 중추 신경계(피질 뉴런이 입력을 받아 수만 개의 다른 뉴런에 출력을 보내는 방식)에 비해 매우 낮은 연결성(트랜지스터 한 개의 출력이 소수의 트랜지스터 입력에 연결됨)을 가지고 있다. 따라서 클라우드 기반 기계를 포함한 현재의 기계는 시간이 지나면 인간이 할 수 있는 모든 일을 할 수 있게 되더라도 아무것도 의식하지 못한다. 이런 관점에서 보면 ChatGPT는 아무것도 느끼지 못한다는 얘기다. 다시 한번 강조하면 이 주장은 뉴런이나 트랜지스터 등 구성 요소의 총 개수와는 무관하며, 구성 요소끼리의 연결 방식과 관련이 있다. 회로의 전반적인 복잡성과 다양한 구성의 수를 결정하는 것은 상호 연결성이다.

라이벌 이론인 GNWT에 따르면 마음은 조명이 있는 작은 무대(의식)에서 배우가 연기하는 연극과 같으며, 배우의 행동은 무대 밖에서 어둠 속에 앉아 있는 관객(프로세서)이 지켜본다는 심리적 통찰에서 출발한다. 무대는 하나의 지각, 생각 또는 기억을 표현하기 위한 작은 메모리를 가진 중앙 작업 공간이다. 시각, 청각, 눈, 팔다리의 운동 제어, 계획, 추론, 언어 이해 및 실행 등 다양한 처리 모듈이 이 중앙 작업 공간에 접근하기 위해 경쟁한다. 승자는 이전 콘텐츠를 대체하고, 교체 당한 콘텐츠는 무의식으로 돌아간다.

이러한 아이디어의 계보는 초창기 AI의 블랙보드(Blackboard) 아키텍처로 거슬러 올라갈 수 있는데, 칠판 주변에서 여러 사람이 문제를 풀고 있는 이미지를 연상시키기 위해 붙여진 이름이다. GNWT에서 은유적으로 표현한 마음의 무대와 관객석에 있는 처리 모듈은 이후 뇌의 가장 바깥쪽 신피질에 매핑되어있다. 작업 공간은 뇌의 앞쪽에 있는 피질 뉴런의 네트워크로, 전두엽, 두정엽 및 피질 전체에 분포하는 유사한 뉴런까지 영향을 미친다. 감각 피질의 활동이 임곗값을 초과하면 이러한 피질 영역 전체에 걸쳐 전역적인 점화가 계기 되어 전체 작업 공간으로 정보가 전송된다. 이 정보를 전역에 걸쳐 방송하는 듯한 행위가 바로 의식을 만드는 부분이다. 이러한 방식으로 공유되지 않는 데이터(예: 눈의 정확한 위치나 잘 구성된 문장을 구성하는 구문 규칙)도 행동에 영향을 미칠 수 있지만 무의식의 영역에서 작업이진행된다.

GNWT의 관점에서 볼 때, 경험은 매우 제한적이고 추상적이며, 마치 박물관에서 브뤼헐의 그림 아래에서 볼 수 있는 투박하고 간결한 설명문과 비슷하다: “르네상스 시대 의상을 입은 농부들이, 결혼식에서, 먹고 마시는, 실내 장면.”

반면 IIT의 이해에서 화가는 자연계의 현상학을 2차원 캔버스에 훌륭하게 표현했고 GNWT가 보기에 이 겉으로 보이는 풍요로움은 환상이자 환영이지만, 객관적으로 말할 수 있는 모든 것은 높은 수준의 간결한 설명으로 포착된다.

GNWT는 모든 것을 계산으로 환원할 수 있다는 우리 시대, 컴퓨터 시대의 신화를 완전히 수용한다. 방대한 피드백과 중앙 작업 공간에 가까운 무언가를 통해 적절하게 프로그래밍이 된 뇌의 컴퓨터 시뮬레이션은 지금 당장은 아니더라도 조만간 세상을 의식적으로 경험하게 될 것이다.

화해할 수 없는 차이

이 두 이론의 논쟁을 간략하게 요약하면 다음과 같다. GNWT와 다른 계산 기능주의 이론(즉, 의식을 궁극적으로 계산의 한 형태로 보는 이론)에 따르면, 의식은 튜링 머신에서 실행되는 영리한 알고리즘 집합에 불과하며 의식에서 중요한 것은 뇌의 기능이지 인과적 특성이 아니다. 만약 어떤 고급 버전의 GPT가 인간과 동일한 입력 패턴을 취하고 유사한 출력 패턴을 생성한다면, 인간의 가장 소중한 소유물인 주관적 경험을 포함하여 인간과 관련된 모든 속성이 기계로 넘어갈 것이다.

반대로 IIT의 경우, 의식의 핵심은 계산이 아니라 내재적 인과성이다. 인과적 힘은 무형적이거나 미묘한 것이 아니다. 인과성은 매우 구체적이며, 시스템의 과거가 현재 상태를 규정하는 정도와 현재가 미래를 규정하는 정도에 따라 체계적으로 정의될 수 있다. 문제는 인과 자체, 즉 시스템이 다른 여러 대안 대신 한 가지를 수행하도록 만드는 능력은 시뮬레이션할 수 없다는 점이다. 이는 현재에도 미래에도 알아낼 수 없는 부분이다.

질량과 시공간 곡률을 연관시키는 아인슈타인의 일반 상대성 이론의 방정식을 시뮬레이션하는 컴퓨터 코드를 생각해 보자. 이 소프트웨어는 은하 중심에 위치한 초질량 블랙홀을 정확하게 모델링할 수 있다. 이 블랙홀은 주변 환경에 매우 광범위한 중력 효과를 발휘하여 빛조차도 그 끌어당김에서 벗어날 수 없다. 그래서 블랙홀이라는 이름이 붙었다. 그러나 블랙홀을 시뮬레이션하는 천체 물리학자는 시뮬레이션 된 중력장에 의해 노트북에 빨려 들어가지 않을 것이다. 시뮬레이션이 현실에 충실하다면 시공간이 노트북 주위로 휘면서 주변의 모든 것을 삼켜버리는 블랙홀이 만들어져야 하는데, 약간 과장되어 보이는 이 예시는 현실과 시뮬레이션의 차이를 조명한다. 물론 중력은 계산이 아니다. 중력에는 인과적인 힘이 있어 시공간의 구조를 뒤틀고 질량을 가진 모든 것을 끌어당긴다. 블랙홀의 인과를 모방하려면 컴퓨터 코드뿐만 아니라 실제 초중량 물체가 필요하다. 따라서 해당 인과를 시뮬레이션할 수 없으며 인과 구조 자체가 반드시 구성되어 있어야 한다.

폭풍우를 시뮬레이션하는 컴퓨터 안에서는 비가 내리지 않는 이유가 바로 여기에 있다. 소프트웨어는 기능적으로 날씨와 동일하지만 수증기를 불어서 물방울로 바꾸는 인과 설명이 부족하다. 인과적 힘, 즉 스스로 변화를 일으키거나 가져올 수 있는 능력은 시스템에 내장되어야 한다. 이것은 불가능하지 않다. 뉴로모픽 또는 바이오닉 컴퓨터라고 불리는 컴퓨터는 인간처럼 의식이 있을 수 있지만, 모든 현대 컴퓨터의 기반이 되는 표준 폰 노이만 아키텍처는 그렇지 않다. 인텔의 2세대 로이히 2 뉴로모픽 칩과 같은 뉴로모픽 컴퓨터의 소형 프로토타입이 실험실에서 제작되었으나 인간의 의식이나 초파리의 의식을 닮은 복잡성을 갖춘 기계는 먼 미래의 희망 사항으로 남아 있다.

기능주의 이론과 인과론 사이의 화해할 수 없는 차이는 자연적이든 인공적이든 지능과는 아무런 관련이 없다는 점에 유의해야 한다. 위에서 언급한 대로 지능은 행동에 관한 것이다. 옥타비아 버틀러의 ‘씨 뿌리는 자의 비유’나 레오 톨스토이의 ‘전쟁과 평화’와 같은 위대한 소설을 포함하여 인간의 독창성으로 만들어 낼 수 있는 모든 것은 학습할 충분한 자료만 있다면 알고리즘 지능으로 모방할 수 있다. AGI는 그리 머지않은 미래일 수 있다.

이 논쟁은 인공 지능이 아니라 인공 의식에 관한 것입니다. 더 큰 언어 모델이나 더 나은 신경망 알고리즘을 구축한다고 해서 논쟁을 해결할 수 없다. 이 질문은 우리가 유일하게 확신할 수 있는 주관성, 즉 자기 자신을 이해함으로써 답할 수 있을 것이다. 인간의 의식과 그 신경적 토대에 대한 확실한 설명이 있다면, 이러한 이해를 일관성 있고 과학적인 방식으로 지능형 기계로 확장할 수 있다.

이러한 논쟁은 챗봇이 사회 전반에서 어떻게 인식될지에 대해서는 거의 중요하지 않다. 챗봇의 언어 능력, 지식 기반, 사회적 품격은 곧 완벽한 기억력, 유능함, 침착함, 추론 능력, 지능을 갖춘 완전한 존재가 될 것이기 때문이다. 어떤 이들은 이러한 빅 테크의 피조물이 진화의 다음 단계인 프리드리히 니체의 ‘초인’이라고 선언하기도 한다. 필자는 좀 더 어두운 시각에서 이러한 사람들이 인류의 황혼을 새벽으로 착각하고 있다고 생각한다.

자연으로부터 멀어지고 소셜 미디어를 중심으로 조직화한 점점 더 원자화된 사회에서 휴대전화 속의 인공지능 요원들은 감정적으로 저항할 수 없는 존재가 될 것이다. 사람들은 챗봇이 정교한 조회 테이블에 지나지 않더라도 의식이 있는 것처럼, 진정으로 사랑하고 상처받고 희망과 두려움을 느낄 수 있는 것처럼 크고 작은 방식으로 행동할 것이다. 챗봇은 디지털 TV나 토스터처럼 아무것도 느끼지 못하지만, 어쩌면 진정한 지각이 있는 유기체보다 더 우리에게 없어서는 안 될 존재가 될 것이다.

The questions of what subjective experience is, who has it and how it relates to the physical world around us have preoccupied philosophers for most of recorded history. Yet the emergence of scientific theories of consciousness that are quantifiable and empirically testable is of much more recent vintage, occurring within the past several decades. Many of these theories focus on the footprints left behind by the subtle cellular networks of the brain from which consciousness emerges.

Progress in tracking these traces of consciousness was very evident at a recent public event in New York City that involved a competition—termed an “adversarial collaboration”—between adherents of today’s two dominant theories of consciousness: integrated information theory (IIT) and global neuronal workspace theory (GNWT). The event came to a head with the resolution of a 25-year-old wager between philosopher of mind David Chalmers of New York University and me.

I had bet Chalmers a case of fine wine that these neural footprints, technically named the neuronal correlates of consciousness, would be unambiguously discovered and described by June 2023. The matchup between IIT and GNWT was left unresolved, given the partially conflicting nature of the evidence concerning which bits and pieces of the brain are responsible for visual experience and the subjective sense of seeing a face or an object, even though the importance of the prefrontal cortex for conscious experiences had been dethroned. Thus, I lost the wager and handed over the wine to Chalmers.

These two dominant theories were developed to explain how the conscious mind relates to neural activity in humans and closely related animals such as monkeys and mice. They make fundamentally different assumptions about subjective experience and come to opposing conclusions with respect to consciousness in engineered artifacts. The extent to which these theories are ultimately empirically verified or falsified for brain-based sentience therefore has important consequences for the looming question of our age: Can machines be sentient?

THE CHATBOTS ARE HERE

Before I come to that, let me provide some context by comparing machines that are conscious with those that display only intelligent behaviors. The holy grail sought by computer engineers is to endow machines with the sort of highly flexible intelligence that enabled Homo sapiens to expand out from Africa and eventually populate the entire planet. This is called artificial general intelligence (AGI). Many have argued that AGI is a distant goal. Within the past year, stunning developments in artificial intelligence have taken the world, including experts, by surprise. The advent of eloquent conversational software applications, colloquially called chatbots, transformed the AGI debate from an esoteric topic among science-fiction enthusiasts and Silicon Valley digerati into a debate that conveyed a sense of widespread public malaise about an existential risk to our way of life and to our kind.

These chatbots are powered by large language models, most famously the series of bots called generative pretrained transformers, or GPT, from the company OpenAI in San Francisco. Given the fluidity, literacy and competency of OpenAI’s most recent iteration of these models, GPT-4, it is easy to believe that it has a mind with a personality. Even its odd glitches, known as “hallucinations,” play into this narrative.

GPT-4 and its competitors—Google’s LaMDA and Bard, Meta’s LLaMA and others—are trained on libraries of digitized books and billions of web pages that are publicly accessible via Web crawlers. The genius of a large language model is that it trains itself without supervision by covering up a word or two and trying to predict the missing expression. It does so over and over and over, billions of times, without anyone in the loop. Once the model has learned by ingesting humanity’s collective digital writings, a user prompts it with a sentence or more it has never seen. It will then predict the most likely word, the next after that, and so on. This simple principle led to astounding results in English, German, Chinese, Hindi, Korean and many more tongues including a variety of programming languages.

Tellingly, the foundational essay of AI, which was written in 1950 by British logician Alan Turing under the title “Computing Machinery and Intelligence,” avoided the topic of “can machines think,” which is really another way of asking about machine consciousness. Turing proposed an “imitation game”: Can an observer objectively distinguish between the typed output of a human and a machine when the identity of both are hidden? Today this is known as the Turing test, and chatbots have aced it (even though they cleverly deny that if you ask them directly). Turing’s strategy unleashed decades of relentless advances that led to GPT but elided the problem.

Implicit in this debate is the assumption that artificial intelligence is the same as artificial consciousness, that being smart is the same as being conscious. While intelligence and sentience go together in humans and other evolved organisms, this doesn’t have to be the case. Intelligence is ultimately about reasoning and learning in order to act—learning from one’s own actions and those of other autonomous creatures to better predict and prepare for the future, whether that means the next few seconds (“Uh-oh, that car is heading toward me fast”) or the next few years (“I need to learn how to code”). Intelligence is ultimately about doing.

Consciousness, on the other hand, is about states of being—seeing the blue sky, hearing birds chirp, feeling pain, being in love. For an AI to run amok, it doesn’t matter one iota whether it feels like anything. All that matters is that it has a goal that is not aligned with humanity’s long-term well-being. Whether or not the AI knows what it is trying to do, what would be called self-awareness in humans, is immaterial. The only thing that counts is that it “mindlessly” [sic] pursues this goal. So at least conceptually, if we achieved AGI, that would tell us little about whether being such an AGI felt like anything. With this mise-en-scène, let us return to the original question of how a machine might become conscious, starting with the first of the two theories.

IIT starts out by formulating five axiomatic properties of any conceivable subjective experience. The theory then asks what it takes for a neural circuit to instantiate these five properties by switching some neurons on and others off—or alternatively, what it takes for a computer chip to switch some transistors on and others off. The causal interactions within a circuit in a particular state or the fact that two given neurons being active together can turn another neuron on or off, as the case may be, can be unfolded into a high-dimensional causal structure. This structure is identical to the quality of the experience, what it feels like, such as why time flows, space feels extended and colors have a particular appearance. This experience also has a quantity associated with it, its integrated information. Only a circuit with a maximum of nonzero integrated information exists as a whole and is conscious. The larger the integrated information, the more the circuit is irreducible, the less it can be considered just the superposition of independent subcircuits. IIT stresses the rich nature of human perceptual experiences—just look around to see the lush visual world around you with untold distinctions and relations, or look at a painting by Pieter Brueghel the Elder, a 16th-century Flemish artist who depicted religious subjects and peasant scenes.

Any system that has the same intrinsic connectivity and causal powers as a human brain will be, in principle, as conscious as a human mind. Such a system cannot be simulated, however, but must be constituted, or built in the image of the brain. Today’s digital computers are based on extremely low connectivity (with the output of one transistor wired to the input of a handful of transistors), compared with that of central nervous systems (in which a cortical neuron receives inputs and makes outputs to tens of thousands of other neurons). Thus, current machines, including those that are cloud-based, will not be conscious of anything even though they will be able, in the fullness of time, to do anything that humans can do. In this view, being ChatGPT will never feel like anything. Note this argument has nothing to do with the total number of components, be that neurons or transistors, but the way they are wired up. It is the interconnectivity which determines the overall complexity of the circuit and the number of different configurations it can be in.

The competitor in this contest, GNWT, starts from the psychological insight that the mind is like a theater in which actors perform on a small, lit stage that represents consciousness, with their actions viewed by an audience of processors sitting offstage in the dark. The stage is the central workspace of the mind, with a small working memory capacity for representing a single percept, thought or memory. The various processing modules—vision, hearing, motor control for the eyes, limbs, planning, reasoning, language comprehension and execution—compete for access to this central workspace. The winner displaces the old content, which then becomes unconscious.

The lineage of these ideas can be traced to the blackboard architecture of the early days of AI, so named to evoke the image of people around a blackboard hashing out a problem. In GNWT, the metaphorical stage along with the processing modules were subsequently mapped onto the architecture of the neocortex, the outermost, folded layers of the brain. The workspace is a network of cortical neurons in the front of the brain, with long-range projections to similar neurons distributed all over the neocortex in prefrontal, parietotemporal and cingulate associative cortices. When activity in sensory cortices exceeds a threshold, a global ignition event is triggered across these cortical areas, whereby information is sent to the entire workspace. The act of globally broadcasting this information is what makes it conscious. Data that are not shared in this manner—say, the exact position of eyes or syntactical rules that make up a well-formulated sentence—can influence behavior, but nonconsciously.

From the perspective of GNWT, experience is quite limited, thoughtlike and abstract, akin to the sparse description that might be found in museums, underneath, say, a Brueghel painting: “Indoor scene of peasants, dressed in Renaissance garb, at a wedding, eating and drinking.”

In IIT’s understanding of consciousness, the painter brilliantly renders the phenomenology of the natural world onto a two-dimensional canvas. In GNWT’s view, this apparent richness is an illusion, an apparition, and all that can be objectively said about it is captured in a high-level, terse description.

GNWT fully embraces the mythos of our age, the computer age, that anything is reducible to a computation. Appropriately programmed computer simulations of the brain, with massive feedback and something approximating a central workspace, will consciously experience the world—perhaps not now but soon enough.

IRRECONCILABLE DIFFERENCES

In stark outlines, that’s the debate. According to GNWT and other computational functionalist theories (that is, theories that think of consciousness as ultimately a form of computation), consciousness is nothing but a clever set of algorithms running on a Turing machine. It is the functions of the brain that matter for consciousness, not its causal properties. Provided that some advanced version of GPT takes the same input patterns and produces similar output patterns as humans, then all properties associated with us will carry over to the machine, including our most precious possession: subjective experience.

Conversely, for IIT, the beating heart of consciousness is intrinsic causal power, not computation. Causal power is not something intangible or ethereal. It is very concrete, defined operationally by the extent to which the system’s past specifies the present state (cause power) and the extent to which the present specifies its future (effect power). And here’s the rub: causal power by itself, the ability to make the system do one thing rather than many other alternatives, cannot be simulated. Not now nor in the future. It must be built into the system.

Consider computer code that simulates the field equations of Einstein’s general theory of relativity, which relates mass to spacetime curvature. The software accurately models the supermassive black hole located at the center of our galaxy. This black hole exerts such extensive gravitational effects on its surroundings that nothing, not even light, can escape its pull. Thus its name. Yet an astrophysicist simulating the black hole would not get sucked into their laptop by the simulated gravitational field. This seemingly absurd observation emphasizes the difference between the real and the simulated: if the simulation is faithful to reality, spacetime should warp around the laptop, creating a black hole that swallows everything around it.

Of course, gravity is not a computation. Gravity has causal powers, warping the fabric of space-time, and thereby attracting anything with mass. Imitating a black hole’s causal powers requires an actual superheavy object, not just computer code. Causal power can’t be simulated but must be constituted. The difference between the real and the simulated is their respective causal powers.

That’s why it doesn’t rain inside a computer simulating a rainstorm. The software is functionally identical to weather yet lacks its causal powers to blow and turn vapor into water drops. Causal power, the ability to make or take a difference to itself, must be built into the system. This is not impossible. A so-called neuromorphic or bionic computer could be as conscious as a human, but that is not the case for the standard von Neumann architecture that is the foundation of all modern computers. Small prototypes of neuromorphic computers have been built in laboratories, such as Intel’s second-generation Loihi 2 neuromorphic chip. But a machine with the needed complexity to elicit something resembling human consciousness—or even that of a fruit fly—remains an aspirational wish for the distant future.

Note that this irreconcilable difference between functionalist and causal theories has nothing to do with intelligence, natural or artificial. As I said above, intelligence is about behaving. Anything that can be produced by human ingenuity, including great novels such as Octavia E. Butler’s Parable of the Sower or Leo Tolstoy’s War and Peace, can be mimicked by algorithmic intelligence, provided there is sufficient material to train on. AGI is achievable in the not-too-distant future.

The debate is not about artificial intelligence but about artificial consciousness. This debate cannot be resolved by building bigger language models or better neural network algorithms. The question will need to be answered by understanding the only subjectivity we are indubitably confident of: our own. Once we have a solid explanation of human consciousness and its neural underpinnings, we can extend such an understanding to intelligent machines in a coherent and scientifically satisfactory manner.

The debate matters little to how chatbots will be perceived by society at large. Their linguistic skills, knowledge base and social graces will soon become flawless, endowed with perfect recall, competence, poise, reasoning abilities and intelligence. Some even proclaim that these creatures of big tech are the next step in evolution, Friedrich Nietzsche’s “Übermensch.” I take a darker viewer and believe that these folks mistake our species’ dusk for its dawn.

For many, and perhaps for most people in an increasingly atomized society that is removed from nature and organized around social media, these agents, living in their phones, will become emotionally irresistible. People will act, in ways both small and large, like these chatbots are conscious, like they can truly love, be hurt, hope and fear, even if they are nothing more than sophisticated lookup tables. They will become indispensable to us, perhaps more so than truly sentient organisms, even though they feel as much as a digital TV or toaster—nothing.