[해외 DS] 사람처럼 학습하면 사람처럼 생각할 수 있을까

네이처지, "사람처럼 일반화할 수 있도록 돕는 새로운 훈련 방법 개발" 합성성을 위한 메타 러닝 접근법, 체계적인 학습 방법이 중요해 한계에도 불구하고 인간과 인공 지능의 학습 과정 이해 실마리 제공

[해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 영어 원문 공개 조건으로 콘텐츠 제휴가 진행 중입니다.

사람들은 새로운 개념을 학습하고 기존 개념과 체계적으로 결합하는 데 능숙하다. 예를 들어 아이가 ‘건너뛰기’를 배우면, ‘뒤로 건너뛰기’ 또는 ‘허들을 두 번 건너뛰는’ 방법을 이해하는 데 큰 어려움이 없다. 많은 사전 지식이 필요한 작업도 아니다.

사람처럼 추론할 수 있는 유연한 머신러닝 모델을 개발하기 위한 핵심은 많은 양의 학습 데이터가 아니라, 새로운 학습 방법이라는 연구 결과가 나왔다. 이러한 연구 결과는 더 나은 인공 지능 모델을 향한 큰 진전이 될 수 있으며, 인공 지능 시스템과 인간이 학습하는 방법의 비밀을 밝히는 데 도움이 될 수 있을 것이라는 기대를 받고 있다.

인간의 일반화 능력, “양보다 체계적인 학습 방법이 더 중요해”

인간은 조합의 달인이다. 사람들이 음식 재료와 같은 일련의 구성 요소 간의 관계를 이해하면 다양한 종류의 맛있는 레시피로 조합할 수 있게 된다. 이는 흔히 인간 인지의 핵심 원리로 여겨지는 ‘합성성'(compositionality) 또는 ‘체계적 일반화'(systematic generalization)에서 비롯된 응용력이다. 머신러닝 개발자들은 수십 년 동안 AI 시스템이 합성성을 가질 수 있다는 것을 증명하기 위해 고군분투해 왔다. 하지만 신경망으로는 해당 수준에 도달할 수 없다는 게 전문가들의 중론이었다. 오늘날의 생성형 AI 모델은 합성성을 모방하여 인간과 유사한 응답을 생성할 수 있는 수준이며, OpenAI의 GPT-3 및 GPT-4를 포함한 가장 진보된 모델조차도 여전히 사람과 같은 일반화 능력엔 미치지 못하는 수준이다.

그러나 25일(현지 시간) 네이처에 발표된 연구에 따르면 인간이 정보를 해석하는 방식으로 AI 모델의 능력을 향상할 수 있다고 한다. 아울러 연구자들은 기존 모델의 아키텍처(트랜스포머)를 근본적으로 바꿀 필요가 없다고 덧붙였다. 이 연구의 수석 저자이자 뉴욕대학교의 컴퓨터 인지 과학자인 브렌든 레이크(Brenden Lake)는 아키텍처를 바꾸기보다 학습 데이터 자체에 메타 러닝 메커니즘을 도입했다고 밝혔다. 고정된 학습 데이터가 아니라 일련의 과제를 동적으로 부여하면서 학습을 안내하는 합성성 접근법(MLC, Meta-learning for Compositionality)을 개발했다. 연구진은 표준 트랜스포머 모델, 즉 ChatGPT와 Google의 Bard를 지원하는 것과 같은 종류의 모델에서 그 효과를 입증하였기에 적용성도 높아 보인다.

단순 모방을 벗어나 진정한 추론에 한 발 다가선 AI

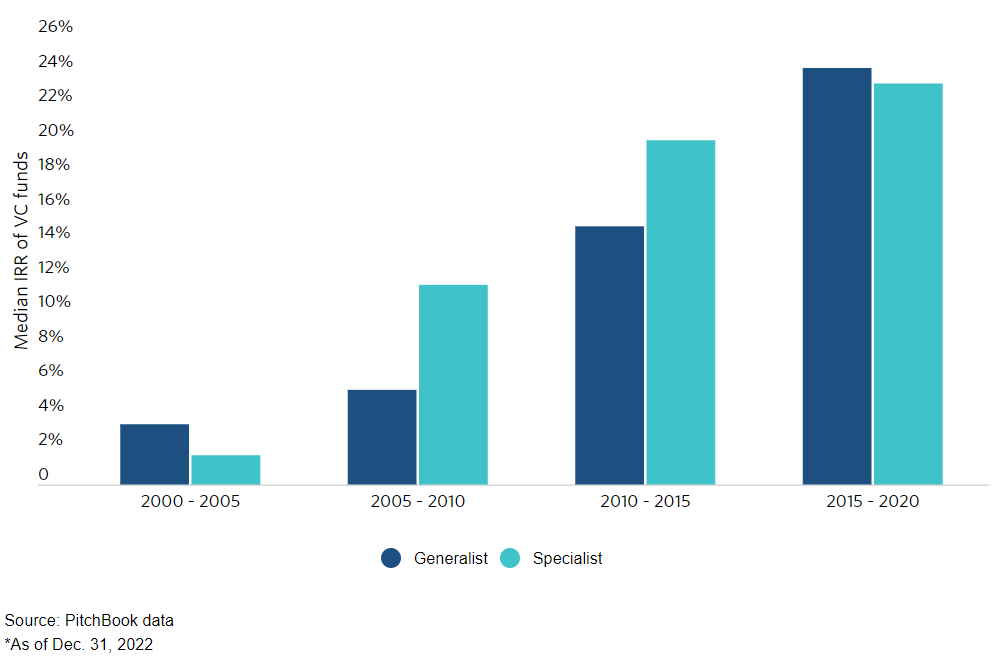

추론 과제에 활용된 언어는 ‘dax’, ‘lug’, ‘kiki’, ‘fep’, ‘blicket’과 같은 난센스 단어로 구성되었으며, 이 단어들은 다양한 색상의 점들로 ‘번역’되었다. 이렇게 발명된 단어 중 일부는 특정 색상의 점을 직접적으로 나타내는 상징적인 용어였고, 다른 일부는 점 출력의 순서나 개수를 변경하는 함수를 의미하기도 했다. 예를 들어 dax는 단순히 빨간색 점을 나타내지만, fep는 dax 또는 다른 기호 단어와 함께 사용하면 해당 점 출력에 3을 곱하는 함수였다. 따라서 ‘dax fep’는 세 개의 빨간색 점으로 해석된다. 합성 함수의 형태로 확장하는 것도 가능하다. 그러나 모델 학습에는 이러한 정보가 전혀 포함되지 않았으며, 연구진은 해당 점 세트와 짝을 이루는 난센스 문장의 예시 몇 개만 모델에 제공했다.

그런 다음 새로운 문구를 입력하여 자체적으로 일련의 점을 생성한 결괏값이 언어에 내재한 규칙을 올바르게 따랐는지에 따라 등급을 매겼다. 언어의 규칙을 ‘이해’하고 훈련되지 않은 문구에 적용 할 수 있는 응용력 덕분에 MLC 기반 모델은 25명의 인간 참가자와 GPT-4보다 더 좋은 성적을 거뒀다. 더 나아가 연구진이 인간의 귀납적 편향1이 들어 있는 행동 예시를 입력하는 실험도 진행했다. MLC 기반 모델은 인간의 추론을 모방하기 시작하여 같은 실수를 저지르기 시작했다. 예를 들어 인간 참가자들은 특정 단어와 점 사이에 일대일 관계가 있다고 가정하는 오류를 자주 범했는데, 실제로는 많은 구문이 그러한 패턴을 따르지 않았지만 모델은 빠르게 편향을 학습하고 사람과 같은 빈도로 오류를 범했다. 인간의 행동이 항상 합리적이지 않다는 미묘한 면마저도 학습할 수 있기에 앞으로 인간의 인지 및 의식을 탐구하는 연구에서 그 활용처가 넓어 보인다.

아직 풀어야 할 과제 남아

하지만 현재로서는 아직 몇 가지 큰 한계점이 남아 있다. 연습 되지 않은 형태의 일반화는 자동으로 처리하지 못한다. 임의의 언어 패턴을 학습하는 한 가지 유형의 작업에서 완전히 새로운 과제를 줬을 때는 같은 기술을 적용할 수 없었다. 이는 벤치마크 테스트에서 MLC 모델이 더 긴 시퀀스를 관리하지 못하고 이전에 도입되지 않은 새로운 단어를 파악하지 못하는 모습에서 확인할 수 있는 단점이었다.

연구진은 머신러닝 연구에서 메타 학습 전략이 유효해지려면 일반화한 결과의 분포가 학습 때의 분포와 같아야 하는데 메타 학습만으론 분포 밖에 있는 에피소드를 해결하기 어려우며, 새로 접한 단어 혹은 상징을 방출시키는 기능도 현재 아키텍처에는 없다고 전했다. 마지막으로 MLC는 자연어의 전체 복잡성과 다른 분야(예: 비전)에 대해 검증되지 않았기 때문에, 모든 측면에서 연습 경험을 통해 인간과 같은 체계성을 갖출 수 있는지는 아직 미지수다.

- 귀납적 편향에는 세 가지 종류가 있다. ‘일대일 관계 편향’은 dax가 점 하나를 의미한다고 가정하는 편향이다. ‘선입선출 편향’은 dax와 lug가 나란히 주어지면 빨간 점(dax)이 파란 점의 왼편에 자리할 것이라고 가정하는 편향이다. ‘상호배타적 편향’은 dax가 빨간점이라는 사전 지식이 있을 때, lug라는 새로운 단어는 빨간 점이 아니라 다른 색상일 것이라고 가정하는 편향이다. ↩︎

New Training Method Helps AI Generalize like People Do

To improve machine learning, the answer might be taking a different approach to robot education rather than just feeding models more data

The key to developing flexible machine-learning models that are capable of reasoning like people do may not be feeding them oodles of training data. Instead, a new study suggests, it might come down to how they are trained. These findings could be a big step toward better, less error-prone artificial intelligence models and could help illuminate the secrets of how AI systems—and humans—learn.

Humans are master remixers. When people understand the relationships among a set of components, such as food ingredients, we can combine them into all sorts of delicious recipes. With language, we can decipher sentences we’ve never encountered before and compose complex, original responses because we grasp the underlying meanings of words and the rules of grammar. In technical terms, these two examples are evidence of “compositionality,” or “systematic generalization”—often viewed as a key principle of human cognition. “I think that is the most important definition of intelligence,” says Paul Smolensky, a cognitive scientist at Johns Hopkins University. “You can go from knowing about the parts to dealing with the whole.”

True compositionality may be central to the human mind, but machine-learning developers have struggled for decades to prove that AI systems can achieve it. A 35-year-old argument made by the late philosophers and cognitive scientists Jerry Fodor and Zenon Pylyshyn posits that the principle may be out of reach for standard neural networks. Today’s generative AI models can mimic compositionality, producing humanlike responses to written prompts. Yet even the most advanced models, including OpenAI’s GPT-3 and GPT-4, still fall short of some benchmarks of this ability. For instance, if you ask ChatGPT a question, it might initially provide the correct answer. If you continue to send it follow-up queries, however, it might fail to stay on topic or begin contradicting itself. This suggests that although the models can regurgitate information from their training data, they don’t truly grasp the meaning and intention behind the sentences they produce.

But a novel training protocol that is focused on shaping how neural networks learn can boost an AI model’s ability to interpret information the way humans do, according to a study published on Wednesday in Nature. The findings suggest that a certain approach to AI education might create compositional machine learning models that can generalize just as well as people—at least in some instances.

“This research breaks important ground,” says Smolensky, who was not involved in the study. “It accomplishes something that we have wanted to accomplish and have not previously succeeded in.”

To train a system that seems capable of recombining components and understanding the meaning of novel, complex expressions, researchers did not have to build an AI from scratch. “We didn’t need to fundamentally change the architecture,” says Brenden Lake, lead author of the study and a computational cognitive scientist at New York University. “We just had to give it practice.” The researchers started with a standard transformer model—a model that was the same sort of AI scaffolding that supports ChatGPT and Google’s Bard but lacked any prior text training. They ran that basic neural network through a specially designed set of tasks meant to teach the program how to interpret a made-up language.

The language consisted of nonsense words (such as “dax,” “lug,” “kiki,” “fep” and “blicket”) that “translated” into sets of colorful dots. Some of these invented words were symbolic terms that directly represented dots of a certain color, while others signified functions that changed the order or number of dot outputs. For instance, dax represented a simple red dot, but fep was a function that, when paired with dax or any other symbolic word, multiplied its corresponding dot output by three. So “dax fep” would translate into three red dots. The AI training included none of that information, however: the researchers just fed the model a handful of examples of nonsense sentences paired with the corresponding sets of dots.

From there, the study authors prompted the model to produce its own series of dots in response to new phrases, and they graded the AI on whether it had correctly followed the language’s implied rules. Soon the neural network was able to respond coherently, following the logic of the nonsense language, even when introduced to new configurations of words. This suggests it could “understand” the made-up rules of the language and apply them to phrases it hadn’t been trained on.

Additionally, the researchers tested their trained AI model’s understanding of the made-up language against 25 human participants. They found that, at its best, their optimized neural network responded 100 percent accurately, while human answers were correct about 81 percent of the time. (When the team fed GPT-4 the training prompts for the language and then asked it the test questions, the large language model was only 58 percent accurate.) Given additional training, the researchers’ standard transformer model started to mimic human reasoning so well that it made the same mistakes: For instance, human participants often erred by assuming there was a one-to-one relationship between specific words and dots, even though many of the phrases didn’t follow that pattern. When the model was fed examples of this behavior, it quickly began to replicate it and made the error with the same frequency as humans did.

The model’s performance is particularly remarkable, given its small size. “This is not a large language model trained on the whole Internet; this is a relatively small transformer trained for these tasks,” says Armando Solar-Lezama, a computer scientist at the Massachusetts Institute of Technology, who was not involved in the new study. “It was interesting to see that nevertheless it’s able to exhibit these kinds of generalizations.” The finding implies that instead of just shoving ever more training data into machine-learning models, a complementary strategy might be to offer AI algorithms the equivalent of a focused linguistics or algebra class.

Solar-Lezama says this training method could theoretically provide an alternate path to better AI. “Once you’ve fed a model the whole Internet, there’s no second Internet to feed it to further improve. So I think strategies that force models to reason better, even in synthetic tasks, could have an impact going forward,” he says—with the caveat that there could be challenges to scaling up the new training protocol. Simultaneously, Solar-Lezama believes such studies of smaller models help us better understand the “black box” of neural networks and could shed light on the so-called emergent abilities of larger AI systems.

Smolensky adds that this study, along with similar work in the future, might also boost humans’ understanding of our own mind. That could help us design systems that minimize our species’ error-prone tendencies.

In the present, however, these benefits remain hypothetical—and there are a couple of big limitations. “Despite its successes, their algorithm doesn’t solve every challenge raised,” says Ruslan Salakhutdinov, a computer scientist at Carnegie Mellon University, who was not involved in the study. “It doesn’t automatically handle unpracticed forms of generalization.” In other words, the training protocol helped the model excel in one type of task: learning the patterns in a fake language. But given a whole new task, it couldn’t apply the same skill. This was evident in benchmark tests, where the model failed to manage longer sequences and couldn’t grasp previously unintroduced “words.”

And crucially, every expert Scientific American spoke with noted that a neural network capable of limited generalization is very different from the holy grail of artificial general intelligence, wherein computer models surpass human capacity in most tasks. You could argue that “it’s a very, very, very small step in that direction,” Solar-Lezama says. “But we’re not talking about an AI acquiring capabilities by itself.”

From limited interactions with AI chatbots, which can present an illusion of hypercompetency, and abundant circulating hype, many people may have inflated ideas of neural networks’ powers. “Some people might find it surprising that these kinds of linguistic generalization tasks are really hard for systems like GPT-4 to do out of the box,” Solar-Lezama says. The new study’s findings, though exciting, could inadvertently serve as a reality check. “It’s really important to keep track of what these systems are capable of doing,” he says, “but also of what they can’t.”