챗GPT 개발사 오픈AI, 브로드컴·TSMC와 자체 AI 칩 개발 착수

오픈AI, 글로벌 반도체 공장 네트워크 구축 철회

브로드컴·TSMC와 협력 통해 엔비디아 의존도↓

AI 반도체 시장 흔드는 빅테크의 '내 칩' 개발 랠리

챗GPT 개발사 오픈AI가 세계 최대 파운드리(반도체 위탁생산) 업체 대만 TSMC에 자체 인공지능(AI) 칩 생산을 맡길 예정이다. AI 반도체 패권을 쥐고 있는 엔비디아에 대한 의존도를 줄이려는 목적으로 풀이된다.

오픈AI, 자사 AI 칩 개발에 삼성·SK 아닌 TSMC와 맞손

29일(현지시간) 로이터통신은 “오픈AI가 칩 공급을 다변화하고 비용을 절감하기 위해 브로드컴과 자체 칩을 개발할 예정”이라고 보도했다. 오픈AI는 자체 칩 개발뿐만 아니라, 엔비디아의 경쟁사인 AMD에서의 AI 칩 조달 비중도 높이기로 했다.

칩 설계는 브로드컴이 맡는다. 브로드컴은 통신용 칩 설계를 전문으로 하는 미국 팹리스(반도체 설계회사)다. 구글의 딥러닝 특화 칩인 텐서프로세서유닛(TPU)과 메타의 AI 칩 ‘미타’ 등이 브로드컴 설계를 기반으로 한다. 중국의 동영상 플랫폼 틱톡 운영사인 중국 바이트댄스도 브로드컴과 AI칩 개발에 나선 바 있다.

제조는 TSMC가 담당한다. 당초 샘 올트먼 오픈AI CEO(최고경영자)는 방대한 AI칩 수요를 충당하기 위한 ‘글로벌 팹(반도체 공장) 네트워크’를 구상, 이를 위해 7조 달러(약 9,300조원)에 달하는 자금 조달 계획을 세웠고, 중동 등지의 투자자들을 다수 만나기도 했다. 하지만 비용과 시간 등의 문제로 해당 계획을 포기하고 설계만 전담하는 방향으로 선회했다. 현재 오픈AI는 내부 반도체 설계 팀을 확장할지, 외부 기업을 인수할지를 고려 중인 상태다. 로이터는 “토마스 노리와 리처드 호를 비롯해 구글에서 TPU을 개발한 엔지니어들이 이끄는 20명가량의 내부 팀이 있지만 다른 파트너와 계약을 맺을 가능성도 있다”고 전했다.

AI 기업에 있어 학습과 추론의 기반이 되는 대형언어모델(LLM) 유지를 위해서는 막대한 양의 연산용 칩이 필수적이다. 엔비디아 A100, H100 같은 서버용 AI 연산 그래픽처리장치(GPU)가 대표적이다. AI 기업들은 매년 칩 구입에 수십억 달러를 쏟아붓는다. 이에 오픈AI는 칩 비용을 낮추고 공급을 다변화하기 위해 많은 선택지들을 검토해 왔다. 올트먼 CEO가 지난해 6월과 올 1월 한국을 방문한 것도 이 같은 이유에서였다. 올트먼 CEO는 1월 삼성전자 평택 파운드리 반도체 생산라인을 둘러보며 수주 기대감을 높였지만, 결과적으로 TSMC와 손을 잡은 모습이다.

메타도 자체 개발 차세대 AI 칩 ‘MTIA’ 출시

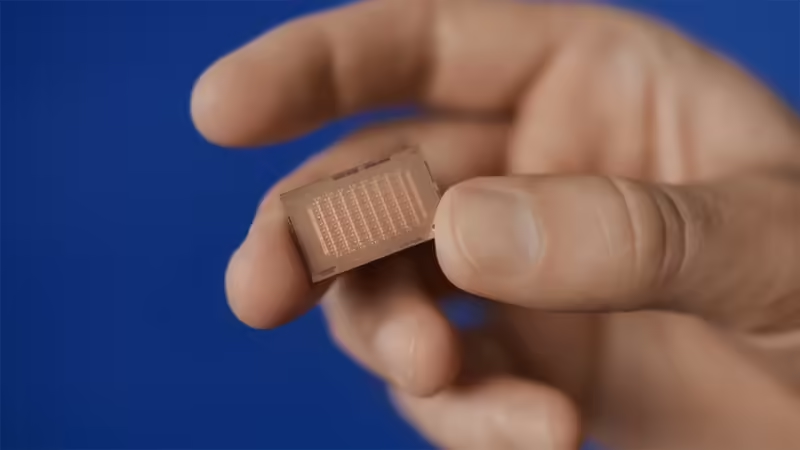

엔비디아에 대한 의존도를 축소하려는 움직임은 메타에서도 포착된다. 지난 4월 메타는 공식 블로그를 통해 ‘메타 학습 및 추론 엑셀러레이터(MTIA, The Meta Training and Inference Accelerator)’ 2세대 반도체의 세부적인 정보를 공개했다. 지난해 5월 1세대를 공개한 지 불과 1년 만이다. 1세대 대비 컴퓨팅 및 메모리 대역폭이 2배 이상 커진 MTIA 칩은 메타가 개발한 추천 광고 및 순위 모델을 효율적으로 구동할 수 있도록 설계됐다.

내부 테스트 결과 차세대 MTIA는 1세대 대비 4개 AI 모델에서 3배 나은 성능을 기록했다. 이번 2세대 MTIA는 AI 추론 작업에 최적화된 PE라 불리는 64개의 컴퓨팅 모듈로 구성된다. PE 전용 데이터 캐시의 용량도 3배 늘어 처리 속도가 2배 이상 향상됐다. 64개의 PE 컴퓨팅 모듈은 해당 캐시로 데이터를 이동할 수 있을 뿐만 아니라 해당 데이터를 서로 공유할 수도 있다.

메모리 반도체로는 HBM(고대역폭 메모리)가 아닌 SRAM이 사용됐으며, 1세대 칩 대비 SRAM 용량도 2배로 늘었다. SRAM과 함께 LPDDR(저전력더블데이터레이트)5 D램 용량 역시 2배 확장됐다. 메타는 차세대 MTIA의 성능 향상에 기여한 또 다른 요인으로 희소 컴퓨팅 파이프라인과 관련된 일련의 개선 사항을 들었다. 이런 불필요한 데이터를 제거해 AI 추론 칩의 계산 속도를 높일 수 있다는 설명이다. 이를 통해 2세대 MTIA는 1세대에 비해 3.5배의 고밀도 컴퓨팅 성능과 7배의 희소 컴퓨팅 성능을 제공한다고 전했다.

메타의 차세대 칩 역시 TSMC의 5나노 공정으로 생산됐으며, 최대 72개의 가속기를 담을 수 있는 대형 랙(rack) 기반 시스템도 함께 개발했다. 여러 개의 가속기를 하나처럼 묶어 더 강력한 연산 성능을 제공하기 위한 설계다. 메타는 또 개발자가 프로세서에서 AI 모델을 보다 쉽게 실행할 수 있도록 맞춤형 소프트웨어 도구를 개발했다. 핵심 요소는 개발자의 AI 모델을 칩이 실행할 수 있는 형태로 바꾸는 ‘트리톤-MTIA(Triton-MTIA)’라는 시스템이다. 트리톤-MTIA는 파이토치(PyTorch)를 포함한 다른 오픈 소스 기술과도 통합된다.

구글도 자체 AI 반도체 선보여

구글도 자체 AI 반도체 제작에 몰두하고 있다. 지난달 AI 연구 부서인 구글 딥마인드는 칩 레이아웃을 설계할 수 있는 ‘AI 알파칩(AlphaChip)’을 발표했다. 알파칩은 바둑 AI ‘알파고'(AlphaGo)나 게임 AI ‘알파제로'(AlphaZero)와 유사한 접근 방식을 채택해 칩 레이아웃 설계를 게임처럼 처리한다. 이를 통해 짧으면 몇 주에서 길면 몇 달이 걸리는 레이아웃 설계를 단 몇 시간 만에 완료할 수 있다.

알파칩은 기존 IC 칩에서 부품 간의 관계를 학습하고 일반화해 다른 칩 레이아웃 설계에 활용하는데, 이를 통해 더 빠른 처리가 가능하다. 이미 실제 칩 설계에도 사용되고 있다. 구글이 올해 자체 설계한 AI 특화 칩 TPU에는 2020년 이후 출시된 TPU v5e, TPU v5p, 트릴리움(Trillium) 세 가지 모델에 알파칩이 활용되고 있다. 또 지난 4월 출시된 Arm 프로세서 액시온(Axion)에도 알파칩이 사용됐다.

구글은 알파칩을 타사에도 제공하고 있다. 대표적인 고객사가 애플이다. 애플은 자체 AI 시스템인 ‘애플 인텔리전스’의 기반이 되는 AI 모델을 구글의 클라우드 TPU 클러스터에서 학습시켰다. 애플이 구글의 AI 칩을 장착한 클라우드 서버를 활용해 AI 모델을 개발했단 의미다. 대만 팹리스 기업 미디어텍도 스마트폰용 칩 다이멘시티 5G(Dimensity 5G)의 개발에 알파칩을 채택한 것으로 알려졌다.